Поиск

Показаны результаты для тегов 'схема'.

Найдено 1 результат

-

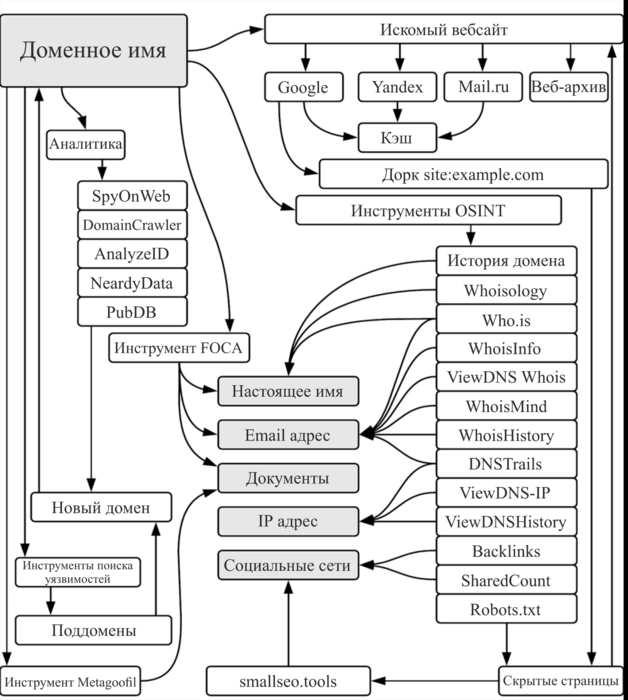

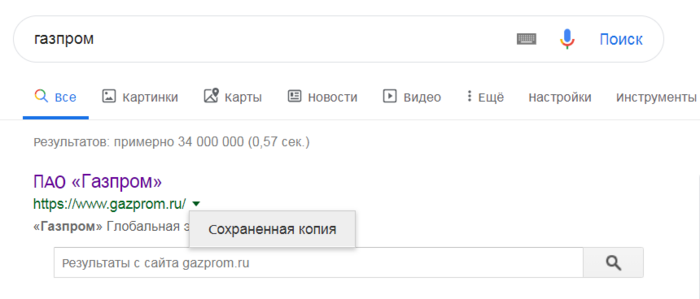

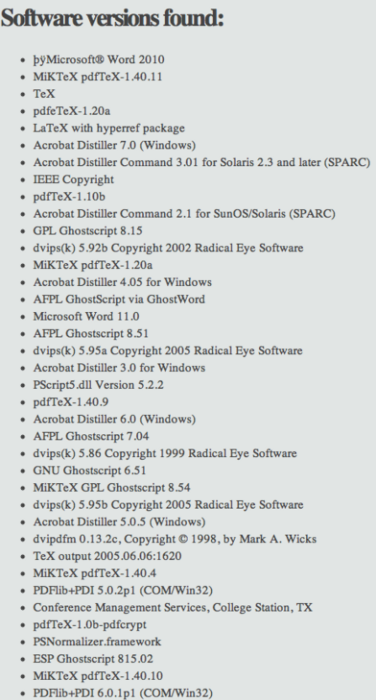

Продолжаем серию статей о OSINT. В этой статье будет рассмотрена схема по методам сбора информации о сайте, а также анализе материалов, размещенных на нем, эксперта по osint , Майкла Баззела. Он указал множество инструментов и онлайн-сервисов для анализа. О них сегодня и пойдёт речь. Итак, вот сама схема: Она интересна прежде всего обильным количеством всевозможных инструментов, необходимых для сборов информации. Т.к. схема предельна проста и понятна, не вижу смысл рассматривать ее принцип, поэтому остановимся только на инструментах и сервисах. Прежде всего хотелось бы остановиться на некоторых блоках таблицы - Веб-архив и кэш. Веб-архивы - это сервисы, которые с помощью своих роботов создают электронные копии сайтов преимущественно в автоматическом режиме. В результате, можно посмотреть, как сайт выглядел в определенные промежутки времени. Самый крупных из них - это archive.org, который насчитывает более 373 миллиарда электронных страниц. Также в русском домене присутствуют такие архивы, как web-arhive.ru и webarchiveorg.ru Кэш - некоторые поисковые системы вроде Yandex и Google кэшируют страницы на случай, если они станут недоступны. Однако с помощью кэша можно также посмотреть информацию, которая недавно была удалена с сайта. Чтобы просмотреть кэш страницы в гугле, нужно нажать на зеленую стрелку возле поисковой выдачи с сайтом. Ветка "Аналитика". SpyOnWeb- сервис, позволяющий находить сайты, которые располагаются на одном IP. Поиск осуществляет по pub Adsense, ua Google Analytics, доменному имени, IP адресу и DNS Servers. Может пригодиться, если необходимо найти всю сеть сайтов конкурента. DomainCrawler - репозиторий на питоне. Цель - сбор информации о сайтах . Возможноси: поиск домена, IP , тип веб-сервера, технического стека, электронной почты, страны-хостинга, MetaGenerator. AnalyzeID - аналог SpyOnWeb. Ищет сайты, которые связаны с Adsense , Google Analytics , партнеркой Amazon , электронной почтой. NeardyData - поисковая система, предназначенная специально для поиска исходного кода. Это позволяет искать программные ключевые слова, HTML, JavaScript или CSS код как есть. PubDB - основная информация о сайте + приблизительная его стоимость. Ветка "Инструменты OSINT". Ветка состоит в основном из инструментов, читающих информацию whois. Whois - это служба, которая предоставляет основную информацию о зарегистрированном домене, такую как контактная информация владельца домена, статус доступности домена и компания, в которой зарегистрирован домен (также называемый регистратором). Whois также предоставляет даты регистрации и окончания срока действия домена, а также серверов имен, используемых доменом. Правила ICANN требуют, чтобы все владельцы доменов сохраняли свои контактные данные действительными и актуальными, чтобы предотвратить мошенничество и кражу личных данных. Вкратце опишу только самые крупные сервисы. Whoisology - это обратная база данных whois / ownership, доступная для поиска, с более чем одним миллиардом отдельных записей доменных имен, которые регулярно обновляются. Реверсивный whois используется для расследования киберпреступности / InfoSec, корпоративной разведки, юридических исследований, развития бизнеса Who.is - предоставляет ценную информацию о домене, такую как регистратор домена, статус, срок действия и серверы имен DNS. Результаты сервиса также включают информацию о местонахождении IP и IP, информацию о веб-сервере, доступность соответствующего домена, списки доменов премиум-класса и многое другое. Whois.ru - русскоязычный сервис whois. Кроме основной информации о домене, показывает его описание, если оно есть. DNSTrails - Крупнейший в мире архив историй DNS. Предоставляются данные для компаний, занимающихся вопросами безопасности, исследователей и групп, которым необходимо выполнить детализацию, найти подозрительные изменения в записях DNS и предотвратить мошенническую или преступную деятельность в будущем. Backlinks - бэклинки или обратные ссылки. Любая ссылка, которая ссылается на другой ресурс - является backlinks. Существуют сервисы, позволяющие посмотреть информацию о том, какие сайты ссылаются на искомый ресурс. Один из самых крупных - ahrefs. В русскоязычном сегменте - megaindex, который имеет бесплатную пробную версию с ограничениями. Robots.txt - самый интересный блок в ветке. Файл Robots.txt располагается в корневой папке сайта и служит в первую очередь для поисковых роботов. В этом документе есть своя структура и директивы, этот документ выполняет функцию «фильтра». В Robots.txt владельцы сайта определяют, какой контент они хотят, чтобы поисковые системы сканировали, а какой не должен попасть в общий индекс. В статье про поиск по доркам я указывал пример нахождения нужной информации, которую индексируют сайты. При грамотно настроенном robots.txt эта информация не попала бы в интернет. Посмотреть его можно, дописав к сайту. Пример: https://www.gazprombank.ru/robots.txt. Данный запрос позволяет находить скрытый от поисковиков контент и использовать в своих целях. У нас осталось 2 инструмента - smallseo.tools и metagoofil. Оба этих инструмента интересны и заслуживают внимания. Smallseo.tools - исходя из названия в первую очередь интересен для специалистов поисковой оптимизации (SEO). Однако, на сервисе есть множество полезных инструментов. Анализатор ссылок - показывает открытые все ссылки домена + внешние ссылки на сайт. Google cash checker - показывает дату создания последней архивной копии сайта. Google index checker - показывает количество проиндексированных страниц. Кроме того: инструмент для интернет-пинга, определение IP-адреса определенного домена, анализ домена, определение своего ip и браузера и множество других полезных инструментов. Metagoofil - является инструментом для Kali Linux. А если он попал во встроенный инструментарий Kali, то в пользе этого инструмента не стоит сомневаться. Что же он делает? Он собирает все метаданные с сайта. Работает со следующими типами документов: pdf, doc, xls, ppt, docx, pptx, xlsx. Увы, с изображениями поработать не получится. Вот пример того, как программа собирает информацию о программном обеспечении: