Поиск

Показаны результаты для тегов 'osint'.

Найдено 5 результатов

-

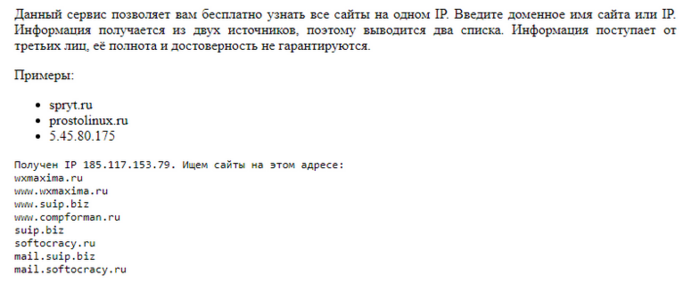

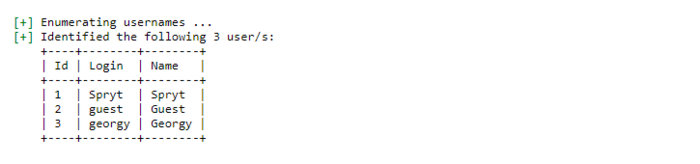

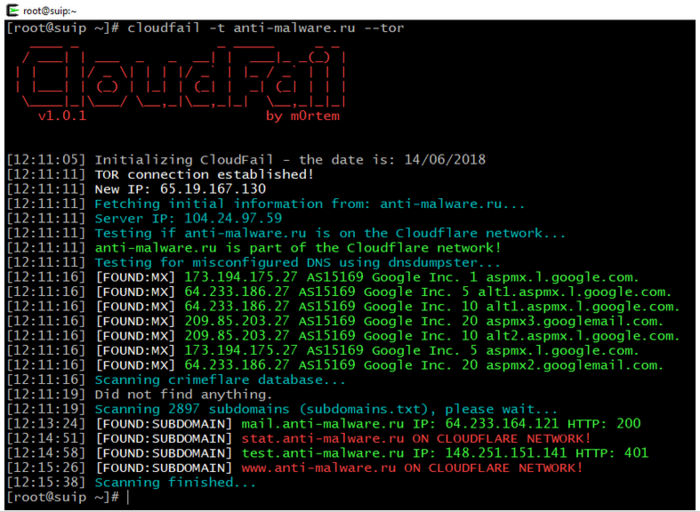

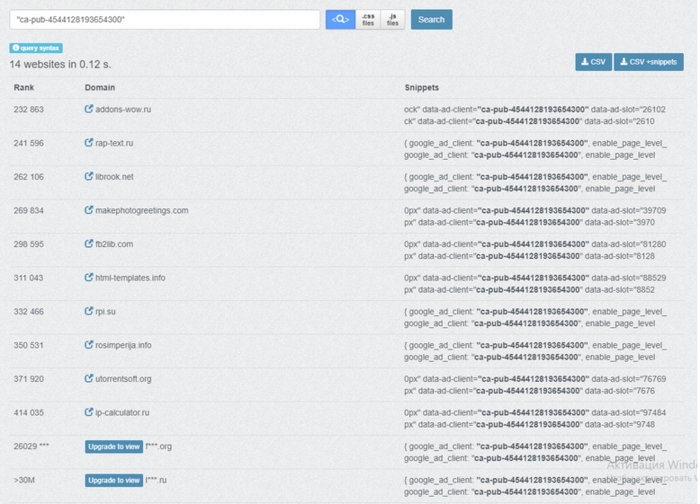

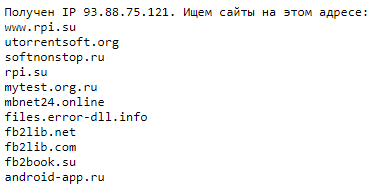

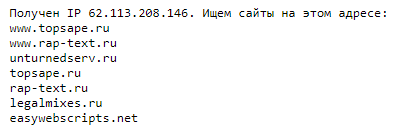

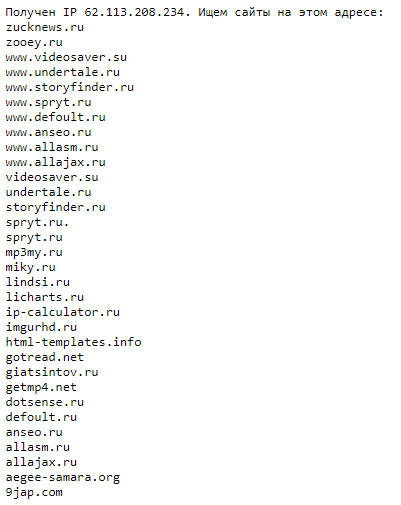

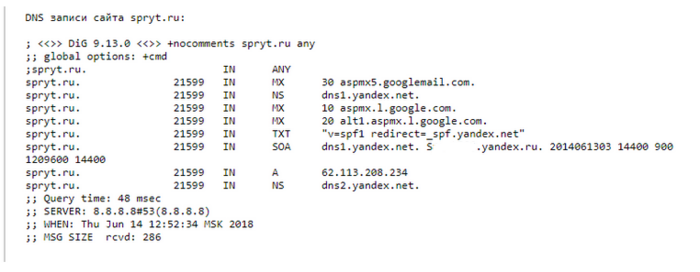

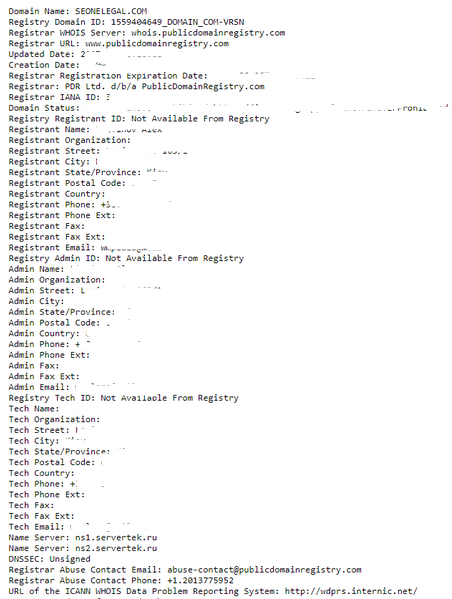

Это НЕ пошаговый мануал как нужно делать. Это статья – довольно базовый набросок об используемых для этой задачи приёмах. Будут рассмотрены возможности поиска по открытым источникам – те методы и инструменты, которые доступны абсолютно любому. Если кто-то при регистрации домена в качестве имени указал "левое" имя или спрятался за CloudFlare, это не означает, что его нельзя идентифицировать. Поиск владельца сайта, который не хочет представиться, обычно заключается в поиске фрагментов информации, которая позволяет его идентифицировать по другим источникам. К примеру, на сайте «анонима» (либо в SOA записи DNS) найден e-mail, а гугление этого адреса привело на сайт с объявлениями о поиске сотрудников. Это объявление может содержать ФИО, телефон, город, дополнительную информацию по интересующему лицу. Поиск дополнительных подтверждений, в том числе гугление по только что найденному номеру телефона, – и «дело» можно считать раскрытым (владелец сайта идентифицирован). Совсем безалаберные анонимы быстро кончаются, поэтому остаются самые хитрые, которые не оставляют таких явных зацепок. Задача получает дополнительный этап – предпринимаются попытки найти другие сайты неизвестного лица, и уже на этих сайтах найти зацепки для идентификации личности. Как искать сайты одного человека. При поиске сайтов одного веб-мастера мы исходим из следующего: иногда владелец нескольких сайтов размещает их все на одном сервере. Т.е. для поиска других сайтов нам нужно узнать IP сервера, где размещён сайт и найти все сайты на одном IP адресе; владелец сайта часто использует уникальные идентификаторы, которые не меняются на разных сайтах. Это могут быть фрагменты кода партнёрских сетей (например, уникальный для каждой учётной записи индикатор содержится в коде вызова объявлений Google AdSense, eBay), счётчики (например, Google Analytics) и прочее; веб-мастера имеют тенденцию использовать одинаковые технологии на разных серверах, иногда сайты загружают ресурсы (изображения, файлы CSS стилей, JavaScript библиотеки) с других сайтов этого же веб-мастера, либо имеют взаимные URL ссылки. Начнём с рассмотрения используемых приёмов и инструментов, а затем изучим несколько кейсов-расследований. Поиск сайтов на одном IP. Адрес сервиса: https://suip.biz/ru/?act=hostmap Ищет сайты на одном IP, можно вводить доменное имя сайта, либо его IP адрес. Поисковая система по исходному коду Адрес сервиса: https://publicwww.com Поиск фрагментов кода, подписей или ключевых слов в HTML, JS и CSS коде веб-страниц. Позволяет искать: Любой HTML, JavaScript, CSS и простой текст в исходном коде веб-страниц Сайты с одинаковым id налитики: "UA-19778070-" Сайты, использующие одинаковый аккаунт AdSense: "pub-9533414948433288" Сайты под управлением WordPress использующие одинаковую тему: "/wp-content/themes/snowfall/" Поиск связанных сайтов через общие уникальные HTML коды, такие как ID виджетов и издателей Идентификация сайтов, использующих конкретные изображения и бейджи. Синтаксис запросов на Publicwww.com Поиск только по доменам определённых зон При желании можно ограничить результаты поиска только конкретными доменами верхнего уровня. Примеры: site:de bootstrap site:it bootstrap site:edu bootstrap site:legal bootstrap Поиск по фразе Когда вы помещаете слово или фразу в двойные кавычки, результат будет содержать только сайты с этими же словами, в том же порядке, что и фраза в кавычках. Т.е. Пример: "math.min.js" Комбинирование фраз Комбинирование поиска по нескольким фразам или ключевым словам. Пример: "<html lang=\"fr\">" bootstrap Оператор НЕ Когда вы используете знак минус перед словом или ключевой фразой, то она исключает сайты с ней из ваших результатов поиска. Пример: "amcharts.js" -bootstrap Экранирование внутренних кавычек Для использования двойных кавычек в поисковых запросах, их нужно экранировать обратным слешем: Пример: "<html lang=\"fr\">" Двойной обратный слеш Если нужно использовать в поисковой фразе обратный слеш, то экранируйте обратный слеш другим обратным слешем. Два последовательных обратных слеша будут интерпретироваться как одиночный обратный слеш. Пример: "\\x5f\\x70\\x6fp" Эксплуатация неправильной настройки DNS для выявления настоящего IP сайта за Cloudflare. Адрес сервиса: https://suip.biz/ru/?act=cloudfail CloudFail – это инструмент тактической разведки, который направлен на сбор достаточной информации о цели, защищенной Cloudflare, в надежде обнаружить местоположение сервера. Используя Tor для маскировки всех запросов, инструмент теперь имеет 3 разных этапа атаки. Сканирование неправильной настройки DNS используя DNSDumpster.com. Сканирование по базе данных Crimeflare.com. Сканирование брут-форсом по 2897 субдоменам. Подробности об использовании здесь, а также в кейсах ниже. Пример отчёта: https://suip.biz/ru/?act=report&id=84f16c83f45bcd9a42a16197ee9c2089 Все DNS записи домена. Адрес сервиса: https://suip.biz/ru/?act=alldns В DNS записях домена иногда можно найти очень интересные вещи. Возьмём, к примеру, домен spryt.ru: Как можно увидеть, используются DNS сервера Яндекса. У Яндекса есть интересная особенность, он записывает в SOA запись почту владельца сайта, в нашем случае там S-------.yandex.ru, т.е. домен связан с учётной записью и почтовым адресом [email protected], это даёт нам ниточку для последующего исследования и поиска по адресу электронной почты. Кроме адресов электронной почты, интересны IP и вообще все необычные записи, которые могут дать толчок для последующих поисков. Если домен защищён сетью CloudFlare, то вместо DNS записей вы получите сообщение: Также все DNS записи домена можно посмотреть прямо в командной строке Linux командой dig: Где ДОМЕН нужно заменить на интересующий домен, например: Журнал xakep.ru тоже использует DNS Яндекса. Воспользуемся этим: Результат: Журнал xakep.ru имеет аккаунт в Яндексе и почту [email protected]. Информация whois. Адрес сервиса: https://suip.biz/ru/?act=whois Информация whois содержит данные об серверах имён домена (Name Server), а также может как содержать детальную информацию о владельце домена (вплоть до фамилии и имени, номера телефона и домашнего адреса до квартиры), так и не содержать чего-либо полезного (быть закрытой). Посмотреть whois домена можно прямо из командной строки Linux: Анализ HTTP заголовков ответа. Адрес сервиса: https://suip.biz/ru/?act=headers К примеру, с помощью CrimeFlare были найдены сайты, принадлежащие, вероятно, одному аккаунту CloudFlare: http://interesnoe.me http://wikiportal.org http://t-catalog.ru Поскольку других зацепок не было, то последним способом подтвердить предположение, что сайты принадлежат одному лицу/находятся на одном сервере, стало сравнение заголовков ответов, каждый из которых содержал строки: Учитывая использование на всех сайтах ASP.NET, а также точное совпадение версии 4.0.30319, а также предыдущие данные об одинаковых NS серверах CloudFlare, можно почти с полной уверенностью утверждать, что это сайты одного человека. Посмотреть HTTP заголовки ответа можно прямо из командной строки Linux: Результаты сканирования WhatWeb. Адрес сервиса: https://suip.biz/ru/?act=whatweb Программа WhatWeb собирает информацию об используемых на сайте технологиях, данная информация может содержать ID аналитики и другую интересную информацию, в том числе для получения «отпечатков» сайта и сервера. Анализ коротких ссылок и ссылок с редиректами. Адрес сервиса: https://suip.biz/ru/?act=hoper Короткие ссылки могут содержать ID реферальных программ и другие интересные данные. Ссылка до достижения конечной цели может пройти множество редиректов. Данный сервис позволяет увидеть все промежуточные пункты, а также конечный URL адрес назначения. Поиск по засветившимся адресам почты, никам и другой информации. В дополнении к publicwww, можно найти много полезного с использованием OSRFramework. Онлайн реализация сервисов OSRFramework: Проверка, где «засветился» адрес электронной почты Поиск профилей по нику пользователя Поиск профилей по полным именам и другой информации Проверка зарегистрированных доменов в разных зонах Поиск метаданных из файлов с сайта. На интересующем сайте могут содержаться файлы с метаданными. Такими файлами могут быть офисные документы (метаданные могут содержать информацию об имени владельца, дату создания/редактирования файла, время правки), изображения (метаданные могут содержать информацию о модели камеры, GPS координаты, где сделана фотография). Дополнительно по данным вопросам: Геолокация фотографий по GPS меткам в метаданных Показать все доступные метаданные файла Анализ HTML кода. Анализ HTML является очень важным этапом. Возможно, именно с него стоит начинать анализ. В HTML могут быть интересными: комментарии. Стоит обращать внимание на содержание, язык комментариев. Комментарии могут «скрывать» ссылки на определённые разделы сайта уникальные идентификаторы для последующего поиска по publicwww, например, идентификатор AdSense, который одинаковый на всех сайтах у одного владельца аккаунта (пример, ca-pub-4544128193654300), или идентификатор Google аналитики, который также одинаковый на всех сайтах одного владельца (пример, UA-28824767-1) особенности исходного кода (необычные имена переменных и функций JavaScript, позволяющие искать по publicwww и прочее) Анализ файла robots.txt В файле robots.txt могут быть закрыты разделы или страницы сайта от индексирования поисковыми системами. У владельца сайта на это имеются причины и это может привести к последующему раскрытию информации. К примеру, при анализе http://interesnoe.me/robots.txt видно, что закрыт от индексации каталог с говорящим названием /js-noindex/. Это позволило предположить, что используется Wap-Click (мошенническая модель монетизации пользователей мобильных устройств, заключается в подключении платных подписок). Поскольку веб-мастеру нужно хотя бы сделать вид, что вап-клик «это честно», то они размещают обращение для пользователя, обычно файл называется message_for_oss. Поиск по стандартному имени позволил найти файл http://interesnoe.me/message_for_oss.pdf. В результате для последующего анализа обнаружен email: [email protected] А в самом файле обнаружены некоторые метаданные, которые могут использоваться в качестве косвенных подтверждений: Перечисление пользователей WordPress. Адрес сервиса: https://suip.biz/ru/?act=wpscan У WordPress может быть множество пользователей. Их имена (ники) могут дать толчок для дальнейшего анализа. Пользователей можно перечислить с помощью WPScan опция (--enumerate u) или используя онлайн сервис, ссылка на который дана выше. Анализ виджетов. Виджеты могут содержать уникальный ID, подходящий для дальнейшего поиска по publicwww, либо из них можно извлечь пользу другим образом. Например, при клике на автора комментария в Disqus, можно увидеть его другие комментарии, в том числе на других сайтах. Анализ ссылок, указывающих на интересующий сайт Эти ссылки могут быть размещены в SEO целях или по другим причинам. Примеры сервисов, для анализа входящих ссылок: https://ru.megaindex.com/l/backlinks https://xtool.ru/backlinks/ Анализ ссылок с сайта. Если интересующий сайт ссылается на другие сайты, то этому тоже могут быть причины. Для поиска таких ссылок можно анализировать исходный код, либо внешние SEO сервисы, например: https://ru.megaindex.com/outlinks Изучение истории whois и предыдущие IP сайта. Иногда информация в whois оказывается закрыта, но раньше она могла быть открыта. Также изменение информации whois может показывать смену владельца и другую информацию. По этой причине имеет смысл изучить историю таких изменений. Видимо, большинство подобных сервисов являются платными. Историю смены IP сайта можно посмотреть бесплатно. Для этого имеется много онлайн сервисов, которые вы можете найти через Гугл. Примеры сервисов, имеющих свои собственные базы (или базу) данных: https://securitytrails.com/dns-trails https://dnshistory.org/dns-records/ http://whoisrequest.com/history/ http://ptrarchive.com/ Сервис, работающий на основе данных VirusTotal: https://suip.biz/ru/?act=domainiphistory Кейс: находим настоящий IP сайта anti-malware.ru и связанные с компанией проекты. Реальный IP сайта anti-malware.ru защищён сетью CloudFlare. Поэтому я использую CloudFail для поиска интересной информации. Я делаю запуск из командной строки: Найден интересный субдомен, который не защищён CloudFlare: Идём на сервис поиска сайтов на одном IP и вводим туда 148.251.151.141: Результат: Итог: практически мгновенно мы обошли защиту CloudFlare и получили пучок сайтов для дальнейшего анализа. А ведь мы даже не заглянули на сам сайт, не анализировали HTML код, не искали уникальные ID, email адреса, не собирали отпечатков серверов и прочее. Все эти методики теперь можно направить на уже полученный список сайтов и составить список всех проектов компании. Кстати, мы могли пойти другим путём и начать с анализа истории смены IP адреса сайта: Как можно убедиться, подтверждён ранее найденный IP, а также мы получили дополнительные адреса (в том числе более свежий IP сервера) для последующего анализа. Кейс: узнаём другие сайты и имя владельца ip-calculator.ru При беглом взгляде на сайт, видим рекламу AdSense, идём в исходный код и ищем идентификатор издателя: Это ca-pub-4544128193654300, переходим на publicwww и ищем по нему: Переходим на сервис поиска сайтов-соседей на одном сервере/IP и ищем каждый из найденных на предыдущем этапе сайтов. Пропустив несколько результатов с shared (совместного) хостинга, получаем списки сайтов: В списке сайтов имеется личный блог владельца, позволяющий установить его личность.

-

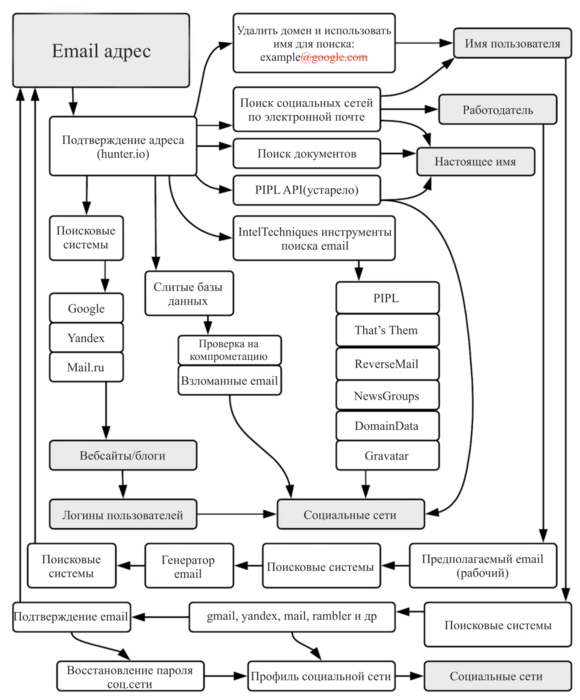

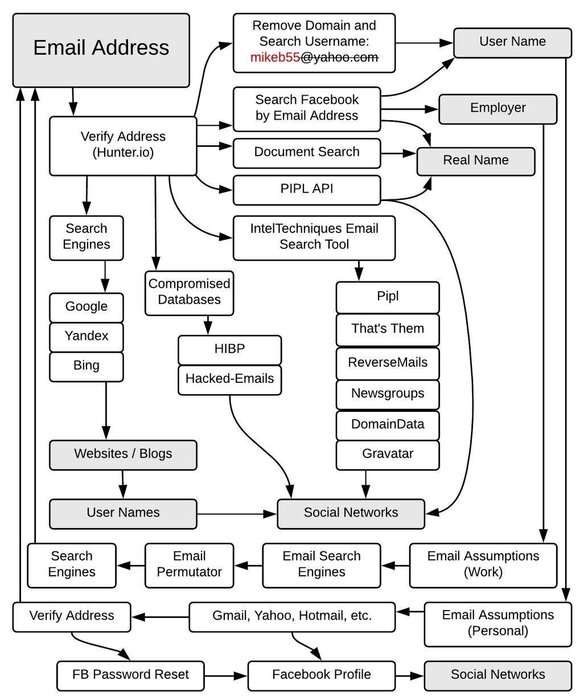

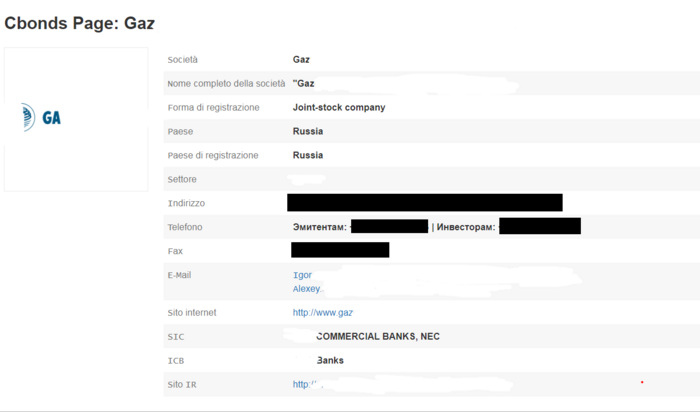

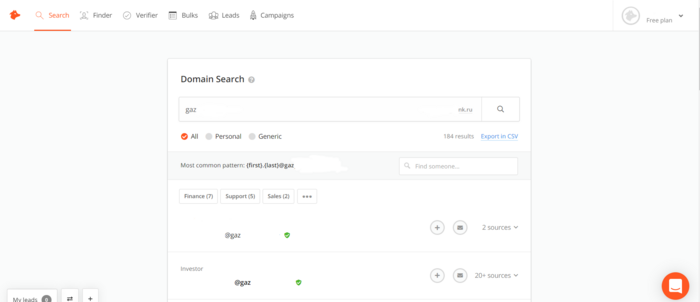

Изучая просторы интернета по OSINT я наткнулся на интересную блок-схему, описывающую процесс сбора информации об email адресе и перевел ее на русский язык. Особенность данной схемы в том, что она подробно описывает порядок достижения нужного результата различными способами, в зависимости от того, какая информация у вас имеется. Как это работает? Давайте попробуем найти профиль сотрудника "одного из множества банков" в социальной сети. Отправляемся на hunter.io и пробуем найти любое упоминание email сотрудников компании. Возьмем первую попавшуюся почту. Сервис замазывает адрес почты в для неавторизированных пользователей, но даёт ссылки на источники, где почта упоминается. Сразу хочу предупредить, что вся информация получена на основе открытых источников, и данной статьей я не побуждаю никого к противоправным целям. Вся информация предоставлена для ознакомления. Возьмем почту из поисковой выдачи. И сразу натыкаемся на источник, где указаны его личные данные: А что если бы это был профиль руководителя какого-нибудь учреждения? В большинстве случаев только этой информации может быть достаточно. Но мы двигаемся дальше. Далее мы ищем его почту без указания домена и тут же натыкаемся на профиль на Linkedin.com, где мы видим, что это DCM Director "одного из множества банков" с указанием его прошлых мест работы. Кроме того, имеются фотографии "Сотрудника" Используя сервисы поиска по изображениям либо FindClone уже можно без проблем выйти на его профиль в социальных сетях. Далее по схеме нужно найти его электронную почту и убедиться, что она принадлежит ему. Сделать это можно опять же с помощью hunter.io. А в ветке поиска рабочего email указан способ "Генератор email", что в оригинале пишется "Email Permutator". Если загуглить на языке оригинала, то можно получить множество сервисов. Например вот: Данный сервис формирует множество возможных Email. По данному запросу сервис сформировал 102 возможных варианта. После того, как мы определились с почтой, пробуем убедиться, есть ли профиль искомого нам человека в социальной сети. В большинстве случаев это можно сделать путём восстановления пароля, когда сервис запрашивает email. Но не будем тревожить нашего "Сотрудника", дабы не возыметь потом неприятностей. На данном примере мы разобрали, как воспользовавшись схемой можно найти профиль человека в социальной сети, отталкиваясь от сайта предприятия. Хотелось бы остановиться на паре моментов схемы. Вот оригинал: Здесь мы видим некий PIPL API и IntelTechniques Email Search Tool. Первое - это API, позволяющий собирать контактную информацию о пользователях. Второе - инструментарий от крупного сервиса по OSINT. В 2019 году многие сервисы, в том числе PIPL API, внесли изменения в свою работу, о чем сказано здесь, в результате чего бесплатный набор инструментов IntelTechniques Email Search Tool устарел. Ко всему прочему бесплатный набор больше недоступен ввиду того, что он использовался в злонамерных целях. А посему проверить его работу в данный момент не представляется возможным. Также интересен способ HIBP. Он заключается в проверка на компрометацию email, то есть можно проверить был ли взломан ваш аккаунт. Вот один из подобных сервисов. Также в даркнете можно найти слитую базу на 1.5 миллиарда пар email/password. По понятным причинам, ссылки публиковать здесь не будем. Спасибо за внимание!

-

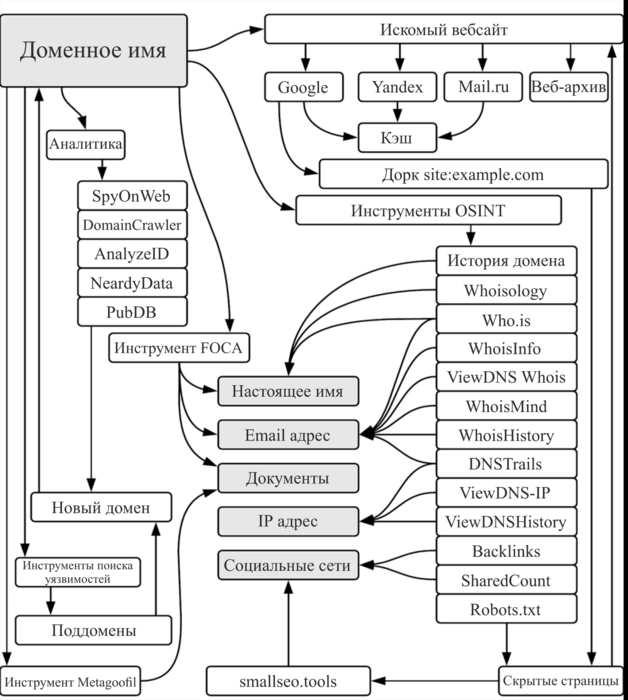

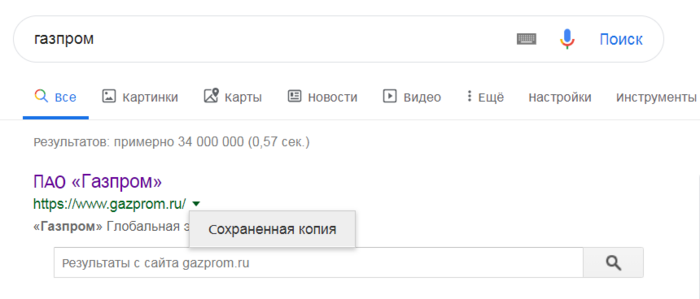

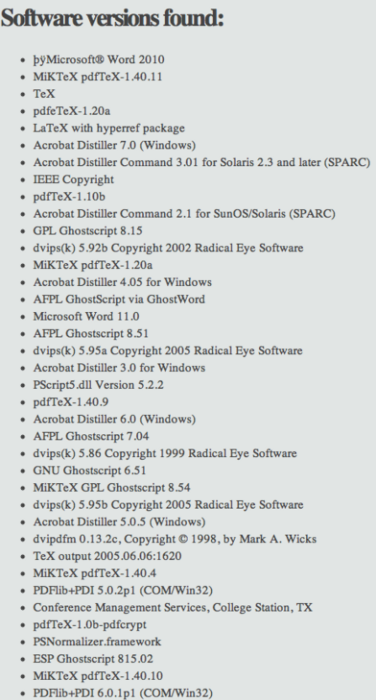

Продолжаем серию статей о OSINT. В этой статье будет рассмотрена схема по методам сбора информации о сайте, а также анализе материалов, размещенных на нем, эксперта по osint , Майкла Баззела. Он указал множество инструментов и онлайн-сервисов для анализа. О них сегодня и пойдёт речь. Итак, вот сама схема: Она интересна прежде всего обильным количеством всевозможных инструментов, необходимых для сборов информации. Т.к. схема предельна проста и понятна, не вижу смысл рассматривать ее принцип, поэтому остановимся только на инструментах и сервисах. Прежде всего хотелось бы остановиться на некоторых блоках таблицы - Веб-архив и кэш. Веб-архивы - это сервисы, которые с помощью своих роботов создают электронные копии сайтов преимущественно в автоматическом режиме. В результате, можно посмотреть, как сайт выглядел в определенные промежутки времени. Самый крупных из них - это archive.org, который насчитывает более 373 миллиарда электронных страниц. Также в русском домене присутствуют такие архивы, как web-arhive.ru и webarchiveorg.ru Кэш - некоторые поисковые системы вроде Yandex и Google кэшируют страницы на случай, если они станут недоступны. Однако с помощью кэша можно также посмотреть информацию, которая недавно была удалена с сайта. Чтобы просмотреть кэш страницы в гугле, нужно нажать на зеленую стрелку возле поисковой выдачи с сайтом. Ветка "Аналитика". SpyOnWeb- сервис, позволяющий находить сайты, которые располагаются на одном IP. Поиск осуществляет по pub Adsense, ua Google Analytics, доменному имени, IP адресу и DNS Servers. Может пригодиться, если необходимо найти всю сеть сайтов конкурента. DomainCrawler - репозиторий на питоне. Цель - сбор информации о сайтах . Возможноси: поиск домена, IP , тип веб-сервера, технического стека, электронной почты, страны-хостинга, MetaGenerator. AnalyzeID - аналог SpyOnWeb. Ищет сайты, которые связаны с Adsense , Google Analytics , партнеркой Amazon , электронной почтой. NeardyData - поисковая система, предназначенная специально для поиска исходного кода. Это позволяет искать программные ключевые слова, HTML, JavaScript или CSS код как есть. PubDB - основная информация о сайте + приблизительная его стоимость. Ветка "Инструменты OSINT". Ветка состоит в основном из инструментов, читающих информацию whois. Whois - это служба, которая предоставляет основную информацию о зарегистрированном домене, такую как контактная информация владельца домена, статус доступности домена и компания, в которой зарегистрирован домен (также называемый регистратором). Whois также предоставляет даты регистрации и окончания срока действия домена, а также серверов имен, используемых доменом. Правила ICANN требуют, чтобы все владельцы доменов сохраняли свои контактные данные действительными и актуальными, чтобы предотвратить мошенничество и кражу личных данных. Вкратце опишу только самые крупные сервисы. Whoisology - это обратная база данных whois / ownership, доступная для поиска, с более чем одним миллиардом отдельных записей доменных имен, которые регулярно обновляются. Реверсивный whois используется для расследования киберпреступности / InfoSec, корпоративной разведки, юридических исследований, развития бизнеса Who.is - предоставляет ценную информацию о домене, такую как регистратор домена, статус, срок действия и серверы имен DNS. Результаты сервиса также включают информацию о местонахождении IP и IP, информацию о веб-сервере, доступность соответствующего домена, списки доменов премиум-класса и многое другое. Whois.ru - русскоязычный сервис whois. Кроме основной информации о домене, показывает его описание, если оно есть. DNSTrails - Крупнейший в мире архив историй DNS. Предоставляются данные для компаний, занимающихся вопросами безопасности, исследователей и групп, которым необходимо выполнить детализацию, найти подозрительные изменения в записях DNS и предотвратить мошенническую или преступную деятельность в будущем. Backlinks - бэклинки или обратные ссылки. Любая ссылка, которая ссылается на другой ресурс - является backlinks. Существуют сервисы, позволяющие посмотреть информацию о том, какие сайты ссылаются на искомый ресурс. Один из самых крупных - ahrefs. В русскоязычном сегменте - megaindex, который имеет бесплатную пробную версию с ограничениями. Robots.txt - самый интересный блок в ветке. Файл Robots.txt располагается в корневой папке сайта и служит в первую очередь для поисковых роботов. В этом документе есть своя структура и директивы, этот документ выполняет функцию «фильтра». В Robots.txt владельцы сайта определяют, какой контент они хотят, чтобы поисковые системы сканировали, а какой не должен попасть в общий индекс. В статье про поиск по доркам я указывал пример нахождения нужной информации, которую индексируют сайты. При грамотно настроенном robots.txt эта информация не попала бы в интернет. Посмотреть его можно, дописав к сайту. Пример: https://www.gazprombank.ru/robots.txt. Данный запрос позволяет находить скрытый от поисковиков контент и использовать в своих целях. У нас осталось 2 инструмента - smallseo.tools и metagoofil. Оба этих инструмента интересны и заслуживают внимания. Smallseo.tools - исходя из названия в первую очередь интересен для специалистов поисковой оптимизации (SEO). Однако, на сервисе есть множество полезных инструментов. Анализатор ссылок - показывает открытые все ссылки домена + внешние ссылки на сайт. Google cash checker - показывает дату создания последней архивной копии сайта. Google index checker - показывает количество проиндексированных страниц. Кроме того: инструмент для интернет-пинга, определение IP-адреса определенного домена, анализ домена, определение своего ip и браузера и множество других полезных инструментов. Metagoofil - является инструментом для Kali Linux. А если он попал во встроенный инструментарий Kali, то в пользе этого инструмента не стоит сомневаться. Что же он делает? Он собирает все метаданные с сайта. Работает со следующими типами документов: pdf, doc, xls, ppt, docx, pptx, xlsx. Увы, с изображениями поработать не получится. Вот пример того, как программа собирает информацию о программном обеспечении:

-

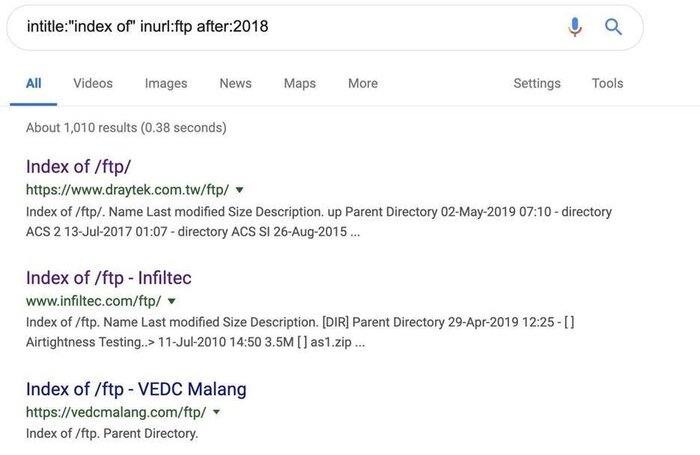

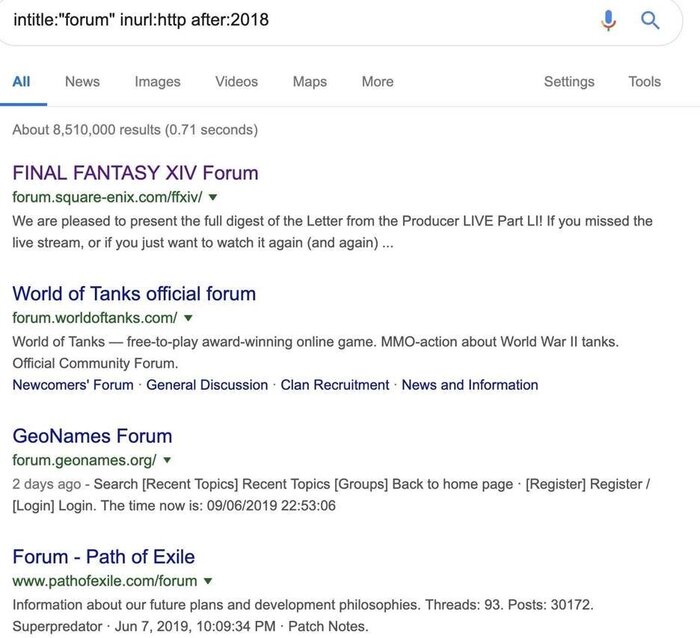

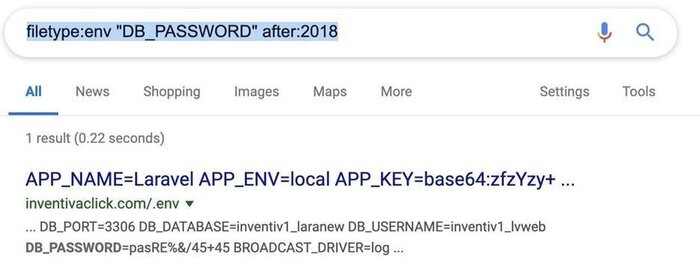

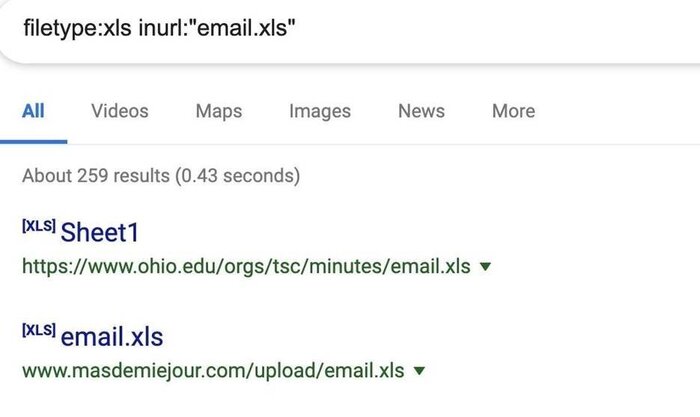

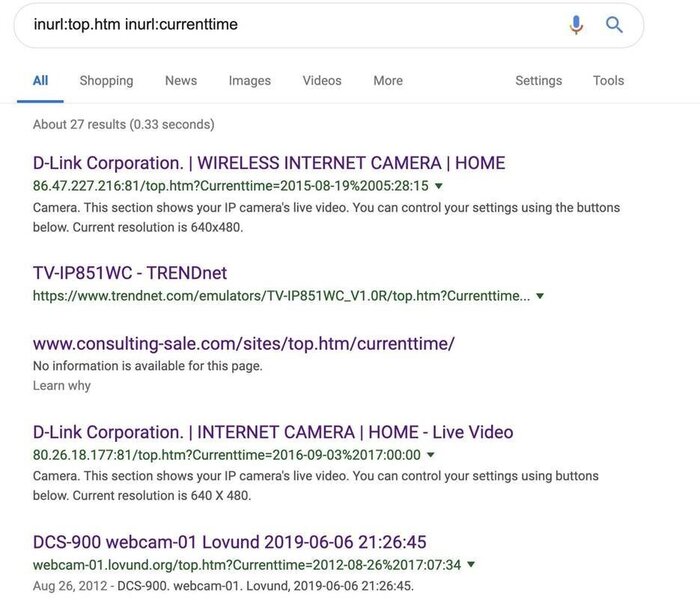

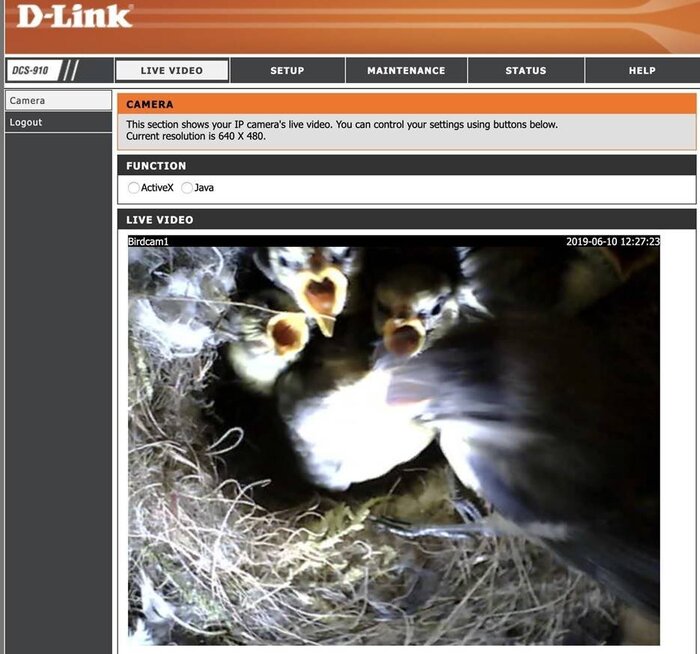

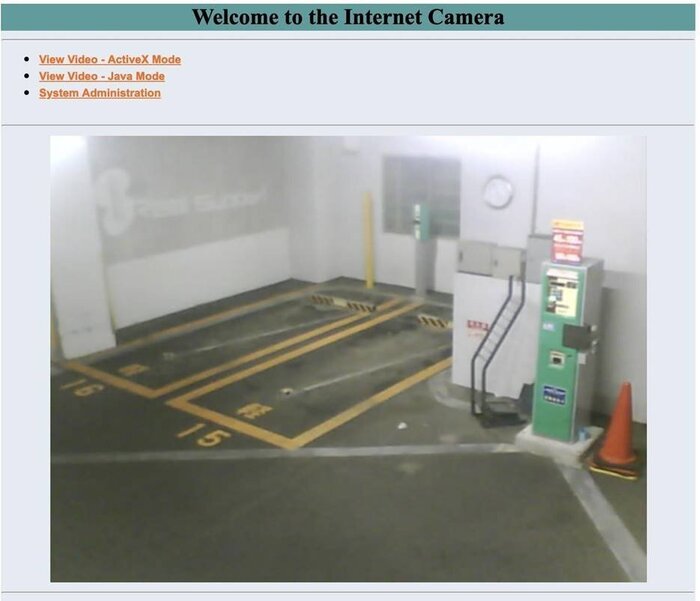

Сегодня мы поговорим с тобой на тему OSINT. Сбор информации из открытых источников — первый этап любого пентеста, и пентеста веб-приложения тоже. Этот этап проводится еще до начала пентеста, чтобы проверить, действительно ли тестируемые объекты принадлежат объекту, или чтобы оценить примерный объем работ для оценки трудозатрат. В методологии этот этап в основном строится на использовании поисковых движков (причем разных, чтобы скомпенсировать ограничения одного преимуществами другого). Здесь тебе на помощь придут операторы поиска и Google Dorks! Google Dorks - мощный инструмент, при помощи которого можно скомпрометировать устройство без лишних телодвижений, используя Google и правильный запрос. Так как эта поисковая система умеет индексировать все, что подключено к интернету, можно найти файлы, оказавшиеся доступными случайно и содержащие конфиденциальную информацию. Google Dorking или дорки представляют собой продвинутые методы использования поисковых операторов и специальных строк для нахождения специфических уязвимых устройств. Если предположить, что Гугл проиндексировал большинство устройств, случайно подключенных к интернету, то мы можем использовать специальный текст со страниц авторизации или административных панелей для поиска этих девайсов. Какие устройства можно найти!? Вы удивитесь, но спектр потенциальных целей довольно широк, начиная от систем управления бассейном на яхте в океане и заканчивая конфигурационными интерфейсами критических систем. Все эти устройства и службы могут оказаться подключенными к интернету, исходя из лучших побуждений, хозяева которых даже не догадываются, что девайс оказался доступным всем и каждому. Как же подобное происходит? Представьте, что у вас появилась камера, доступная через телефон в любое время. После настройки и подключения по Wi-Fi вы скачали приложение для авторизации, и с этого момента у вас есть доступ к камере из любого места! На самом деле, все чуть сложнее. Камера подключается к серверу в Китае и транслирует видеопоток в режиме реального времени, а вы после авторизации можете просматривать видео прямо с телефона. Видеопоток может даже оказаться не защищен паролем и быть доступным всем, кто сформирует правильный запрос для поиска текста, который содержит страница для просмотра трансляции с камеры. К сожалению, Гугл безжалостно эффективен на поприще поиска любых устройств, подключенных к интернету, с запущенными HTTP и HTTPS серверами. Поскольку в большинстве устройств сервер используется для настройки, на всеобщее обозрение попадает многое, что попадать не должно. Какие дорки наиболее полезные? Безусловно, наиболее лакомый файл, который мы можем найти – содержащий учетные записи отдельных пользователей или ко всей службе сразу. Как правило, возможно два сценария. Первый – когда сервер или другая служба настроены некорректно, и административные логи доступны через интернет. В случае смены пароля или неудачи во время авторизации, через эти логи возможна утечка аккаунтов. Второй сценарий – когда становятся доступными конфигурационные файлы, содержащие ту же самую информацию. Предполагается, что эти файлы исключительно для внутреннего пользования, но часто конфиденциальная информация доступна в открытом виде. Оба этих сценария позволяют получить контроль над всей службой в случае, если злоумышленнику удастся найти файлы подобного рода. Мы будем использовать дорки в Гугл с целью поиска не только этих файлов, но и FTP серверов, которые могут содержать интересную информацию, списки электронных почт и доступные вебкамеры. Что понадобится. Вам потребуется браузер и подключение интернету. При использовании дорков для поиска уязвимых систем мы можем использовать инструменты, доступные практически каждому. Откройте браузер и зайдите в google.ru Теперь мы готовы начать. Шаг 1. Поиск FTP серверов и сайтов, работающих по протоколу HTTP Вначале воспользуемся дорком для поиска FTP серверов, опубликованных после 2018 года. Эти сервера позволяют найти файлы, предназначенные для внутреннего пользования, но по незнанию оказавшиеся в публичном доступе. Рисунок 1: Список найденных FTP серверов. Эти сервера становятся публичными, поскольку индексный файл FTP сервера очень любит сканировать Гугл, о чем часто забывают администраторы. После индексации все файлы сервера можно искать через Гугл. Если мы хотим найти небезопасные HTTP-страницы, немного модифицируем запрос выше, изменив «ftp» на «http». В результате поиска можно получить тысячи страниц, использующих HTTP, и готовых к компрометированию. Однако если мы ищем определенный тип сайта, как, например, форум, то модифицируем запрос следующим образом: Мы также можем добавить операторы наподобие AND inurl:"registration", чтобы сделать поиск более целенаправленным (например, небезопасных форм на страницах регистрации). Рисунок 2: Список небезопасных форумов, использующих протокол HTTP Шаг 2. Поиск логов с паролями! Следующий шаг – поиск файлов с расширением .LOG. Файлы подобного рода позволяют выяснить информацию об учетных записях обычных пользователей или администраторов. Для поиска будем использовать следующий дорк: Результаты с логами, доступными через интернет, получаем незамедлительно: Рисунок 3: Во время поиска найден доступный лог проекта OpenCast По логу на рисунке выше видно, что в системе используется стандартный пароль, а сам лог легко найти на сайте проекта OpenCast при помощи простого поискового запроса. В итоге мы, вероятно, обнаружили учетную запись системы без использования изощренных хакерских приемов. Шаг 3. Поиск конфигурационных файлов с паролями Конфигурационные файлы вообще никогда не должны быть доступными извне. Если, к примеру, найти файл с расширением .ENV, содержащий параметр DB_PASSWORD, то, можно сказать, что мы тут же нашли пароль к обнаруженной базе данных. Рисунок 4: Пример конфигурационного файла с паролем к базе данных Если из запроса удалить выражение after:2018, то в результатах появятся более старые конфигурационные файлы, также позволяющие получить доступ к службам через интернет. Шаг 4. Поиск список электронных почт! Сбор списков электронных ящиков – отличный способ поиска информации о различных организациях. Например, эти списки могут использоваться компаниями или школами с целью упорядочивания электронных адресов для своих членов, но часто попадают во всеобщий доступ. Списки электронных почт будем искать в электронных таблицах (файлы с расширением .XLS). В поисковом запросе внутри URL задаем имя файла «email.xls». Рисунок 5: Результаты поиска файлов email.xls Результаты поиска могут оказаться полезными, но следует быть осторожным, чтобы не нарваться на honeypot (горшочек с медом). Многие знают о подобных дорках и намеренно оставляют файлы, которые на первый взгляд кажутся уязвимыми, а на самом деле содержат вредоносы! Шаг 5: Поиск открытых камер Если вы думаете, что Shodan – единственный сервис для поиска открытых камер, то очень ошибаетесь. Обычно страницы авторизации и просмотра камер доступны через HTTP, и Гугл будет счастлив проиндексировать эти документы. Соответственно, найти подобного рода информацию также не составит труда при правильном поисковом запросе. Один из наиболее распространенных запросов содержит имя «top.htm» для поиска в URL вместе с текущем временем и датой. Используя нижеуказанный дорк, вы получите много результатов: Рисунок 6: Результаты поиска открытых камер Ландшафт, снимаемый первой камерой в результатах поиска, больше всего похож заставку в Windows XP и находится где-то в городе Белмаллет (Ирландия). Рисунок 7: Изображение одной из найденных камер Еще один дорк для поиска камер, позволяющий получить отличные результаты для страниц, хранимых на роутерах. При помощи этого дорка я смог найти нечто очень интересное, а конкретно – камеру, следящую за гнездом птиц (birdcam1): Рисунок 8: Одна из камер, найденная во время поиска страниц lvappl.htm Другие камеры не являются столь интересными, как birdcam1. Рисунок 9: Камера внутри коттеджного поселка Также можно найти камеры внутри фабрик и промзон: Рисунок 10: Камера внутри мастерской Все вышеуказанные камеры доступны без пароля. Однако многие дорки позволяют найти страницы авторизации камер, использующих стандартные пароли. Эта тактика хоть и является нелегитимной, но позволяет получить доступ ко многим камерам, которые не предназначены для широкой публики. Заключение. Поскольку Гугл индексирует практически все, что подключено к интернету и имеет веб-интерфейс, мы легко можем найти некорректно настроенные устройства и службы. Однако подключаться к этим девайсам лучше не надо, даже если пароль находится в открытом виде, поскольку могут возникнуть проблемы с правоохранительными органами. Если у вас есть служба, подключенная к интернету, стоит протестировать наиболее популярные дорки на ваших доменах. Вдруг вы случайно оставили нечто важное, что может привлечь внимание злоумышленника. Надеюсь вам понравилось это руководство, посвященное доркам для поиска уязвимых устройств и открытых паролей.

-

- 1

-

-

- pentest

- сбор информации

-

(и ещё 1 )

C тегом:

-

OSINT: использование открытых источников информации для разведывательной работы В современном цифровом мире информация является одним из самых ценных активов. Весточки о нашей жизни, наше местоположение, интересы и связи оставляют след в интернете. В то же время, множество полезных данных можно найти в открытых источниках, которые доступны каждому. Именно здесь приходит на помощь OSINT (открытый источник информации). OSINT - это процесс сбора, анализа и использования информации из общедоступных источников для получения различных типов данных и разведывательной информации. Включая интернет, публичные базы данных, социальные сети, новостные статьи и другие доступные ресурсы. Основными целями OSINT являются: 1. Сбор информации о конкретных лицах или организациях. OSINT может помочь в поиске информации о людях, их контактах, прошлом занятости, образовании и других подробностях. Это может быть полезно для правоохранительных органов, ведения расследований или проверки анкет при приеме на работу. 2. Анализ общественного мнения. OSINT может использоваться для изучения общественного мнения и настроений. Это может быть полезно для политических кампаний, маркетинговых исследований или прогнозирования трендов. 3. Сбор информации о событиях и местоположении. OSINT позволяет отслеживать актуальные события и получать информацию о местоположении. Это может быть полезно для журналистов, организаторов мероприятий или туристических компаний. 4. Анализ рыночных трендов. OSINT может помочь в сборе данных о рыночных трендах, конкурентной среде и потребительском поведении. Это может быть полезно для бизнеса при принятии стратегических решений и разработке маркетинговых кампаний. Однако, необходимо помнить, что OSINT имеет свои ограничения и риски. Информация, полученная из открытых источников, может быть неполной, неточной или устаревшей. Кроме того, существует потенциальная угроза нарушения конфиденциальности и неправомерного использования информации. Правильное использование OSINT требует компетентности и этичности. При сборе и анализе данных необходимо соблюдать законы и правила конфиденциальности. Также важно учитывать контекст информации и ее достоверность, чтобы избежать ошибочных выводов. В целом, OSINT является мощным инструментом для сбора разведывательной информации из открытых источников. Он используется различными организациями и специалистами для получения ценных данных. Однако, важно использовать его с осторожностью. Расширения браузера, перечисленные на этой странице, доступны в Chrome Web Store. Возможно, вы не найдете все расширения, доступные в Firefox. Удостоверьтесь, что вы понимаете, что делает каждое расширение, и принимайте во внимание вопросы конфиденциальности и безопасности. Эти расширения не являются персональными рекомендациями, и есть и другие расширения, которые выполняют подобные задачи. AI - Искусственный интеллект ChatGPT Assistant (Помощник ChatGPT) Интегрируйте OpenAI ChatGPT в свой поисковик! Получите доступ к ChatGPT на любом веб-сайте с помощью функции помощника Chat GPT. Copyfish Copyfish позволяет копировать, вставлять и переводить текст с любого изображения, видео или PDF. Google Translate (Google Переводчик) Просматривайте переводы легко во время просмотра веб-страниц. Выделите или щелкните правой кнопкой мыши на тексте и нажмите на значок "Перевести". Project Naptha (Project Напфа) Выделите, копируйте, редактируйте и переводите текст с любого изображения в Интернете. Simple Search (Простой поиск) Простой поиск не изменяет страницу поиска, он просто добавляет новый вид сверху, показывая только "традиционные" результаты поиска. You.com (You.com) Познакомьтесь с будущим поиска с помощью генеративного искусственного интеллекта. Glasp (Glasp) YouTube и краткое содержание статей, предоставляемое ChatGPT. Image OSINT (OSINT-анализ изображений) EXIF Viewer Pro Быстрый доступ к EXIF-данным любого изображения, отображаемого в Google Chrome. Exify Показывает информацию EXIF при наведении указателя мыши на фото. Fake Profile Detector (Обнаружение поддельных профилей) Щелкните правой кнопкой мыши на фотографии профиля, наша модель определит, содержит ли изображение, сгенерированное GAN, или реального человека. InVID & WeVerify Этот плагин разработан как "швейцарский нож" для верификации, помогая журналистам, факт-чекерам и защитникам прав человека. PhotOSINT (OSINT-инструмент для изображений) Инструмент OSINT для изображений. Сканирует страницу на наличие изображений с метаданными EXIF во время просмотра. RevEye Reverse Image Search (Обратный поиск по изображению) Выполняет поиск по изображению. Выбирайте между поисковыми системами Google, Bing, Yandex и TinEye. Screenshot YouTube (Скриншот YouTube) Добавляет кнопку "Скриншот" к плееру YouTube, которая сохраняет скриншот текущего видео как файл. Search by Image (Поиск по изображению) Инструмент обратного поиска по изображению с поддержкой различных поисковых систем, таких как Google, Bing, Yandex, Baidu и TinEye. Obfuscation, OPSEC & Privacy (Обфускация, OPSEC и конфиденциальность) BuiltWith Technology Profiler Узнайте, с помощью каких технологий создан веб-сайт, который вы посещаете, используя это расширение. Canvas Fingerprint Defender Защита от определения по отпечаткам Canvas путем отправки фальшивого значения. Chaff Генерирует случайный интернет-трафик для затруднения определения реальных действий во время просмотра страниц. Clear URLS Это расширение автоматически удаляет элементы отслеживания из URL-адресов, чтобы защитить вашу конфиденциальность при просмотре в Интернете. Decentraleyes Защищает вас от отслеживания через "бесплатные", централизованные системы доставки контента. Location Guard (Защита местоположения) Скрывает ваше географическое положение от веб-сайтов. Netcraft Extension (Расширение Netcraft) Обеспечивает подробную информацию о сайте и защиту от фишинга и вредоносного JavaScript при просмотре веб-сайтов. Privacy Badger Privacy Badger автоматически блокирует невидимые трекеры. Terms of Service; Didn't Read (Правила использования: Не прочитано) Получайте мгновенную информацию о правилах использования и политиках конфиденциальности веб-сайтов, с рейтингами и краткими описаниями. uBlock Origin uBlock Origin - это широко-спектровый блокировщик контента. Social Media OSINT (OSINT-анализ социальных медиа) DumpItBlue DumpItBlue - это инструмент, который помогает извлекать данные из Facebook для анализа или отчетности. Image Downloader Находите, выбирайте и загружайте нужные вам изображения с любых веб-страниц или выбирайте все для массовой загрузки изображений. Email Extract Расширение Email Extract ищет адреса электронной почты на посещаемых вами страницах. Email Extractor Email Extractor - это мощное расширение для извлечения электронной почты для Chrome. Расширение автоматически извлекает действительные адреса электронной почты со веб-страницы. L.O.C L.O.C - это набор инструментов, которые помогают пользователям Facebook загружать контент и проводить анализ. Video Downloader Plus Загружайте видео с веб-сайта, включая Facebook, Instagram, Twitter и Vimeo. Return YouTube Comment Username Это расширение заменит "имя пользователя" в разделе комментариев к видео, разделе комментариев сообщества и разделе комментариев верхнего уведомления на ваше старое имя пользователя. vidIQ Vision for YouTube (vidIQ Vision для YouTube) Анализатор YouTube. Раскройте секреты успеха ваших любимых видео на YouTube. Веб-сайты OSINT BuiltWith Technology Profiler Узнайте, с использованием этого расширения, на каких технологиях построен веб-сайт, который вы посещаете. Country Flags Отображает флаг страны местоположения сервера веб-сайта, информацию Whois и географическую информацию. Distill Web Monitor Мониторит веб-страницу или фид на предмет изменений. Получайте SMS- и электронные уведомления о обнаружении изменений. Google Similar Pages Находит веб-страницы, похожие на ту, которую вы просматриваете в данный момент. Instant Data Scraper Извлекает данные с веб-страниц и экспортирует их в файлы Excel или CSV. Linkclump Позволяет открывать, копировать или добавлять в закладки несколько ссылок одновременно. Link Gopher Извлекает все ссылки с веб-страницы, сортирует их, удаляет дубликаты и отображает их в новой вкладке для копирования и вставки в другие системы. OpenLink Structured Data Sniffer Раскрывает структурированные метаданные (Microdata, RDFa, JSON-LD, Turtle и т. д.), встроенные в HTML-документы. Page Monitor Остается в фоновом режиме и отслеживает изменения на веб-страницах. Pulsedive Threat Intelligence Выделяет IP-адреса, домены и URL-адреса на любом веб-сайте для обогащения их с помощью бесплатного набора данных по угрозам Pulsedive. Save Page WE Сохраняет полную веб-страницу (как отображается в данный момент) в виде одного HTML-файла, который можно открыть в любом браузере. Simple Search Простой поиск не изменяет страницу поиска, он просто добавляет новое представление сверху, показывающее только "традиционные" результаты поиска. Tag Assistant Tag Assistant помогает устранить проблемы с установкой различных тегов Google, включая Google Analytics, Google Tag Manager и другие. ThreatPinch Lookup Универсальный инструмент для информационной безопасности и OSINT для вашего браузера. Исследуйте меньше, беря свой контекст с собой. Visualping Visualping - простой сервис для мониторинга изменений на веб-сайтах. Wayback Machine Добро пожаловать в официальное расширение Wayback Machine от Internet Archive! Путешествуйте во времени, чтобы увидеть, как изменился веб-сайт за историю Интернета. Web Archives Просмотр архивированных и кэшированных версий веб-страниц в 10+ поисковых системах.