Поиск

Показаны результаты для тегов 'proxmox'.

Найдено 9 результатов

-

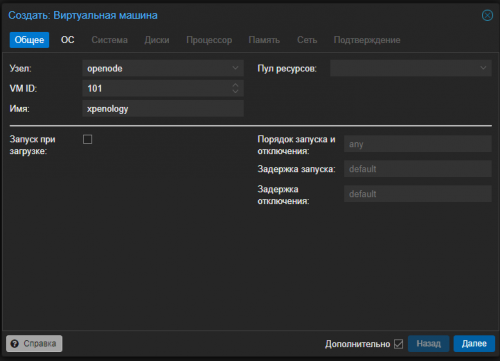

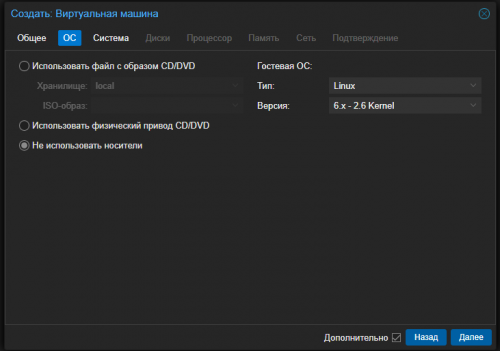

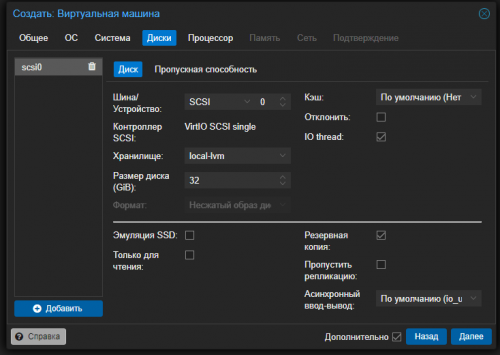

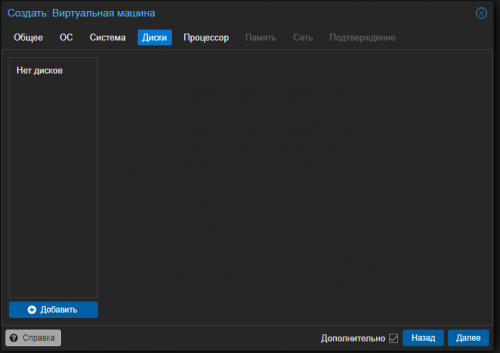

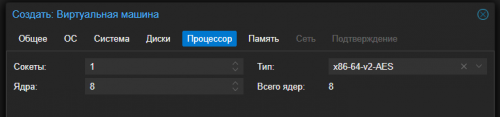

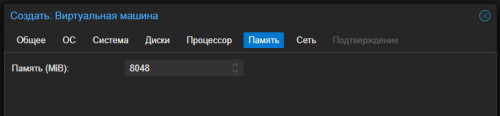

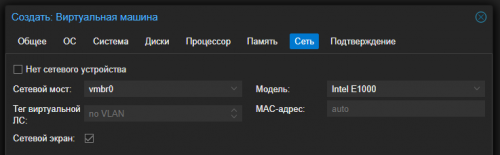

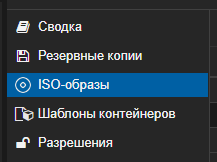

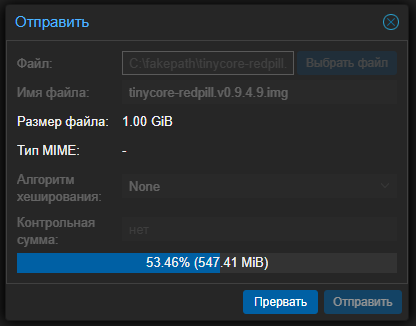

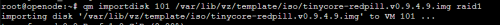

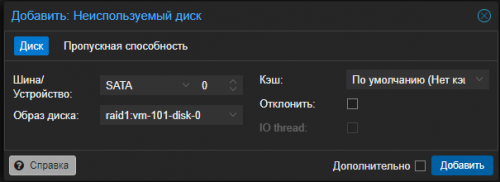

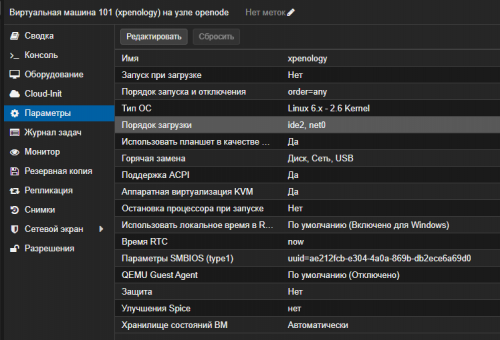

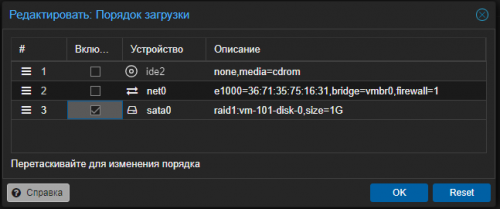

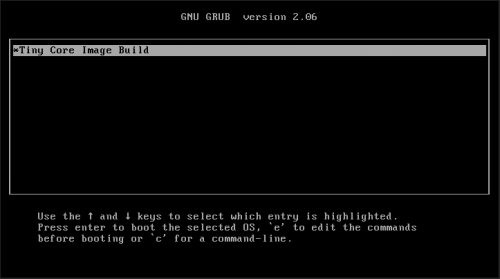

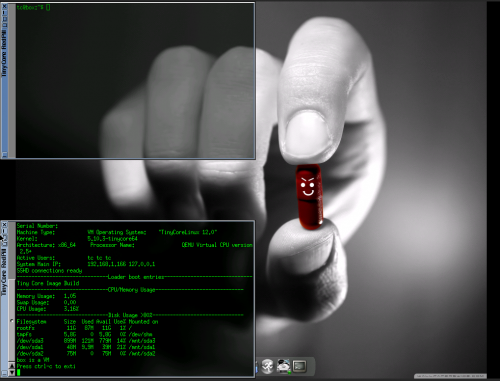

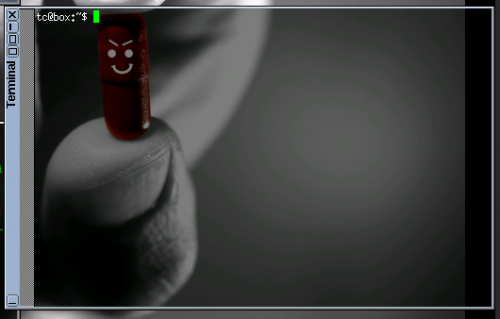

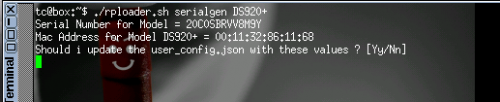

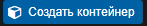

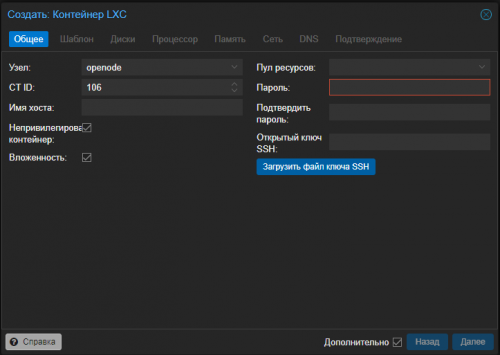

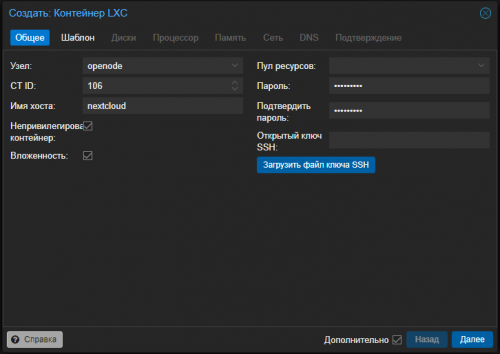

Без предисловий. 1. Начинаем с создания Виртуальной машины 2. Задаем имя 3. На вкладке ОС выбираем, что мы не будем устанавливать с диска 4. На вкладке Диски - удаляем Диск scsi0 кнопкой корзины. Должно стать так: 5. Задаем Процессорные мощности как вам угодно. Я хочу ресурс быстрый, задаю побольше 6. Задаем Память (рекомендую не меньше 6-8гб) 7. На вкладке Сеть задаем Intel E1000 (это важно!) 8. Идем дальше и создаем машину. 9. Идём по адресу: Releases · pocopico/tinycore-redpill (github.com) 10. Выбираем файл tinycore-redpill.v0.9.4.9.img.gz и качаем: (нужен именно он, но версия у может отличаться) В моём случае страница выглядела так: 11. Скачанный файл, распаковываем на своем компьютере чтобы у вас получился файл с раширением .img 12. Переходим в Proxmox =- local =- ISO образы 13. Жмём Отправить и выбираем наш распакованный файл: 14. Переходим Proxmox Оболочку: 15. Пишем команду: qm importdisk <VMID> /var/lib/vz/template/iso/tinycore-redpill.v0.9.4.9.img <STORAGE_LOCATION> Здесь: <VMID> - заменяем на номер нашей виртуальной машины. (у меня это 101) Исправляем имя файла - если оно у вас другое <STORAGE_LOCATION> - заменяем на название вашего диска, который будет основным хранилищем. 16. Переходим в Оборудование нашей VM и видим что подключился наш диск: 17. Выделяем строку с диском и жмём Редактировать. Там меняем тип диска на SATA и жмем Добавить: 18. Теперь идём в Параметры и выбираем строку Порядок загрузки =- Редактировать 19. Включаем наш SATA0 и отключаем все остальные строки: 20. Переходим в Консоль и жмём Старт 21. Жмём Enter в GRUB: 22. Откроется окно: UPD: Здесь конечно лучше и удобнее подключиться просто через терминал. написал отдельное сообщение: 23. Жмем самую правую кнопку Терманала 24. Внутри набираем текст (я выбрал DS920+): ./rploader.sh serialgen DS920+ 25. Система спросит подтверждения 26. Теперь пишем команду: ./rploader.sh build 27. Прокручиваем вверх, ищем нашу сборку и выбираем желаемую версию Операционки Synology: Я выбрал ds920p-7.2.0-64570 28. Теперь пишем команду: ./rploader.sh build ds920p-7.2.0-64570 29. Ещё раз подтверждаем что хотим обновиться до новой версии (может и не быть, тогда должен быть результат что все установлено: 29.1. И ЗАПУСКАЕМ КОМАНДУ ИЗ ПУНКТА 28 ЕЩЁ РАЗ! 30. Жмём самую левую иконку Exit и выбираем Shutdown 31. Когда Виртуальная Машина отключится, выбирайте вкладку Оборудование =- Добавить =- Жесткий диск 32. Выбирайте ваше хранилище, и указывайте объем места 20Гб 33. Теперь можно запускать нашу виртульную машину. 34. Пока ждем запуска, идём по адресу: Synology Archive Download Site - Index of /download/Os/DSM И загружаем желаемую версию себе на комп. 35. Теперь идем по адресу: https://find.synology.com 36. В открытом окне выбираем наше устройство: 37. Идём дальше Установить 38. Теперь выбираем наш скачанный файл: При этом, я бы рекомендовал бы отключить Автоматическое обновление НА ЭТОМ ВСЁ. Теперь вам необходимо будет "пробросить" туда свой жесткий диск для основного хранилища и создать там Пул. В этом руководстве рассматривалось, как установить Xpenology на Proxmox. Общий процесс установки Xpenology на Proxmox не особенно сложен, но в целях подлинности и надежности вам действительно следует приобрести Synology NAS. Это отличный способ протестировать ОС и определить, нравится ли она вам, но устройство, приобретенное напрямую у Synology, будет иметь гораздо большую поддержку. Спасибо, что ознакомились с руководством по установке Xpenology на Proxmox. Если у вас есть какие-либо вопросы о том, как установить Xpenology на Proxmox, пожалуйста, оставьте их в комментариях!

- 2 ответа

-

- proxmox

- proxmox 8 ve

-

(и ещё 1 )

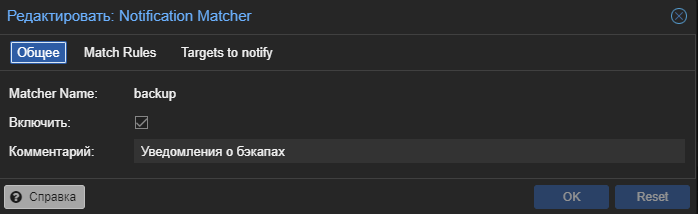

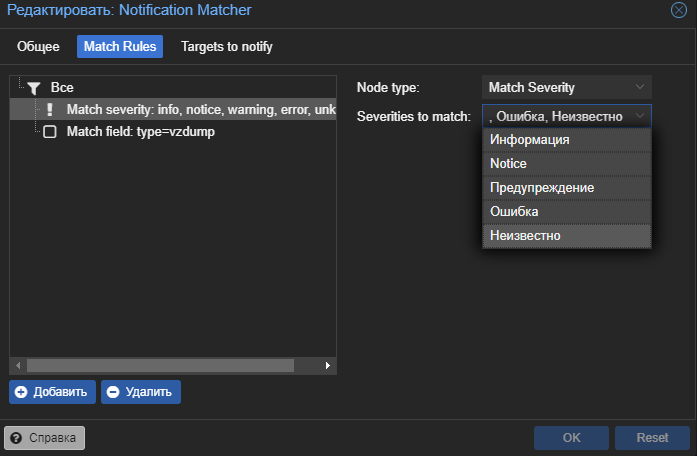

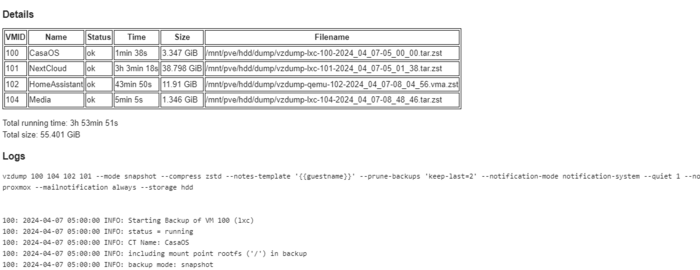

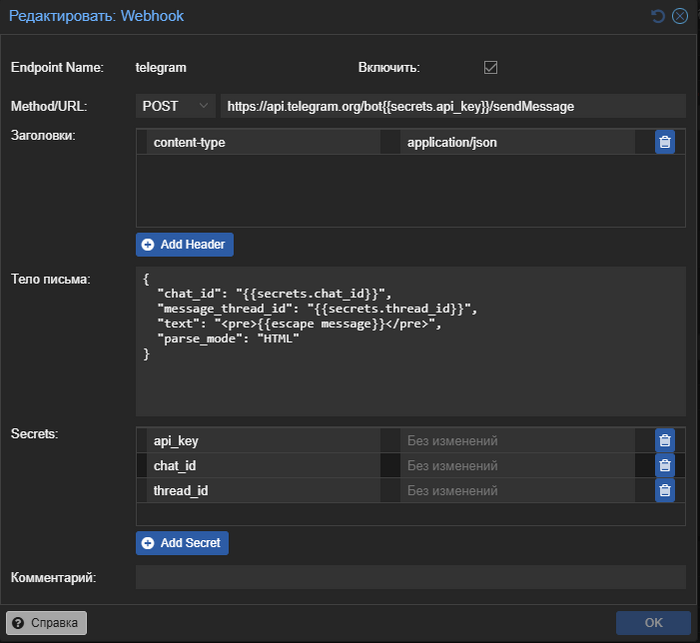

C тегом:

-

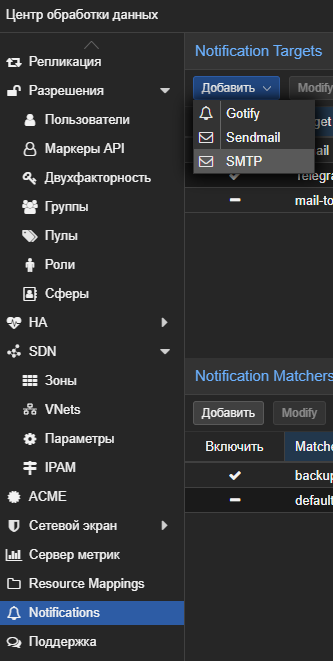

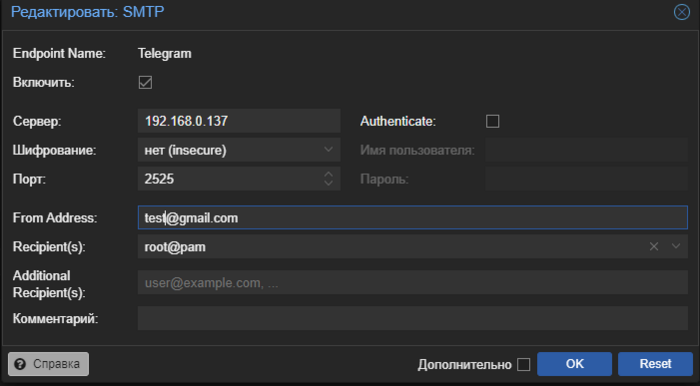

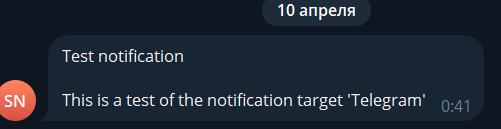

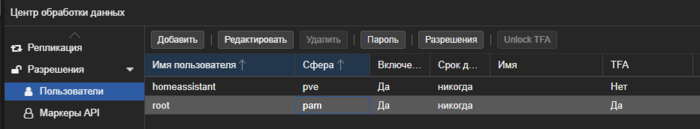

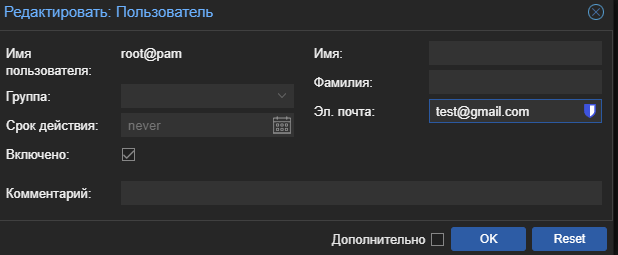

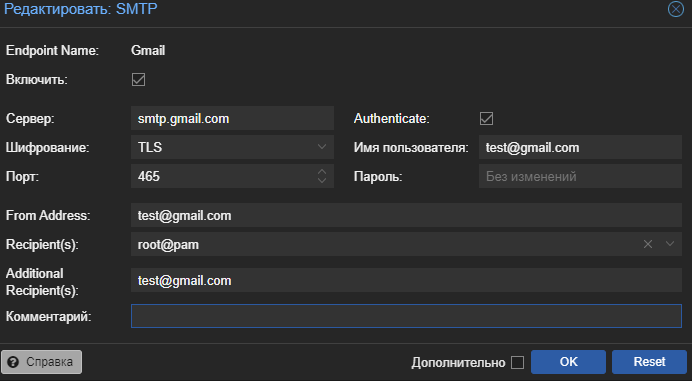

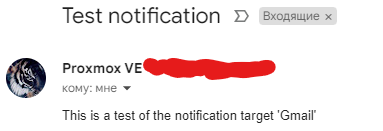

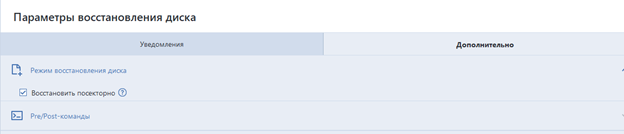

Это небольшая заметка о том как буквально за 10 минут организовать пересылку уведомлений из системы Proxmox VE в телеграмм. Небольшое вступление В один не очень приятный момент я столкнулся с тем что резервное копирование proxmox из за ошибки не выполнялось несколько дней, а так как эксперименты над виртуалками с моей стороны очень частые для меня это очень плохой звоночек. В один не очень хороший момент я мог просто не найти бэкап на который рассчитывал. Для предотвращения подобной ситуации в будущем решил настроить уведомления в proxmox. Сама система proxmox поддерживает три типа уведомлений: smtp, gotify и встроенную отправку почты linux. По умолчанию настроен вариант отправки почты linux, но из коробки это решение работать не будет и все уведомления оседают где то в логах системы. Рассмотрим два других варианта более подробно: Gotify - интересная легкая система которая может удобно собирать по http все уведомления в одном месте. И... на этом все... как по мне в ней не хватает как минимум адекватной возможности пересылки в другие системы. Smtp - это классическая почта, фактически вы даете данные авторизации для отправки почты от вашего имени (или от имени специального почтового ящика). Вариант использовать почту был уже более приемлемый но хотелось все таки получать уведомления в телеграмм (у меня уже были ранее настроены уведомления для watchtower, sonar, radar и т.д.). На просторах интернета есть несколько ботов которые подключаются к proxmox api Для управления системой, но по большей степени это именно управление и уведомления они не получают, ну и для задачи это было избыточно. В сухом остатке имеем два пути решения задачи Gotify или Smtp, причем приложение Gotify работает по принципу что именно приложение идет за сообщением а не сервер отправляет на телефон, это серьезное ограничение которое требует внешний доступ к серверу Gotify. Простое и элегантное решение UPD 03.03.25: В proxmox появилась возможность отправлять уведомления с использованием вебхуков теперь настройка еще проще На просторах интернета и обсуждений проблемы в telegram каналах было найдено простое и элегантное решение, smtp_to_telegram. Это небольшое приложение поднимает smtp сервер для приема писем без авторизации и пересылает их в telegram бот. Данный метод можно использовать не только для proxmox но и для любого сервиса поддерживающего smtp отправку уведомлений. Подробнее о самом решении можете посмотреть на странице GitHub: https://github.com/KostyaEsmukov/smtp_to_telegram Фактически нам необходимо создать телеграмм бота (или использовать уже имеющийся) который будет только отправлять сообщения, но не будет читать. Это позволяет без проблем использовать одного бота для нескольких уведомлений как например для watchtower (автоматического обновления докер образов). На просторах интернета множество инструкций по созданию телеграмм ботов подробно расписывать не буду. Коротко идем к служебному боту https://t.me/BotFather и создаем нового бота через меню, нам надо от него токен API. Не забываем написать нашему боту что нибудь для запуска. Так же с помощью https://t.me/myidbot необходимо узнать наш id для отправки сообщений, все опять таки крайне просто пишем боту /getid и получаем циферки которые нам нужны. Само решение будем запускать как я люблю в докере, так как это банально проще и легко воспроизводится: version: '3' services: readeck: container_name: SmtpToTelegram image: kostyaesmukov/smtp_to_telegram:latest restart: unless-stopped volumes: - /DATA/AppData/readeck:/readeck environment: - ST_TELEGRAM_CHAT_IDS=779979797 - ST_TELEGRAM_BOT_TOKEN=7127345363:AAEarsdfsdtnYsZZasdasdx0OfFcDc1NLU - ST_TELEGRAM_MESSAGE_TEMPLATE={subject}\n\n{body}\n\n{attachments_details} ports: - 2525:2525 Сам автор проекта не очень коммуникабельный и не собирает дорабатывать как либо решение, или банально делать образ докера под arm64 но есть альтернативный вариант под эту архитектуру. Для arm64 используйте образ image: cobra1978/smtp_to_telegram После запуска докер контейнера на нашем сервере на порту 2525 поднимется smtp сервер пересылки без авторизации. Переходим в настройку proxmox, нас интересует раздел notification у центра обработки данных. Создадим новую цель уведомлений smtp с данными для нашего сервиса пересылки (сервер это ip нашего сервера на котором запущен докер контейнер пересылки): Фактически отправитель и получатель могут быть вообще любыми адресами у сервиса нет контроля релевантности адресов кроме общего шаблона <name>@domein Фактически все у нас есть возможность отправлять уведомления proxmox в телеграмм, нажимаем test и видимо сообщение от бота. Если не сработало проверьте что у пользователя заполнен почтовый адрес Настройка уведомлений на почту Кроме бота можно настроить еще и дополнительно уведомления на почту, я для таких целей использую свой же почтовый ящик gmail. Но необходимо выполнить несколько предварительных настроек. Установить у пользователя proxmox почту. Для этого переходим в управление пользователями proxmox, и заполняем для пользователя от имени которого будем отправлять уведомления электронный адрес. Следующий пункт это получение пароля приложения для нашей почты которая будет выполнять отправку. Каждый почтовый сервис имеет свои правила и настройки, но большая часть современных требует создания пароля приложения с ограниченными правами. Для гугл можно посмотреть тут: https://support.google.com/accounts/answer/185833?hl=ru После получения пароля возвращаемся в раздел уведомлений proxmox и создаем новую цель для рассылки smtp, для своего почтового сервиса ищите настройки в поиске по словам "smtp <название вашего сервиса>" Обратите внимание что получатель и отправитель (настраивается в пользователе) почты могут совпадать, это будет письмо самому себе. Нажимаем тест и проверяем почту. Отправителя по умолчанию можно выключить, но удалить не получиться. Уведомления о бэкапах proxmox В proxmox существует достаточно гибкая система условий для уведомлений, подробно о ней можно почитать тут https://pve.proxmox.com/wiki/Notifications Я приведу небольшой пример который я использую для получения уведомлений о бэкапах как успешных так и ошибочных. Переходим в раздел уведомлений proxmox и создаем новый Notification Matchers Данные настройки будут отправлять на телеграмм и почту сообщение о событиях бэкапа в любое время. Для дополнительных ограничений по времени или других типов событий рекомендую ознакомится с документацией. Пример уведомления о бэкапах в телеграмм, к сообщению дополнительно прикладывается лог. Телеграмм бот дополнительно прикладывает его в виде файла так как не всегда удобно читать логи в сообщении телеграмм. И оно же на почте Спасибо за внимание, удачной настройки и меньше тревожных ведомлений.

-

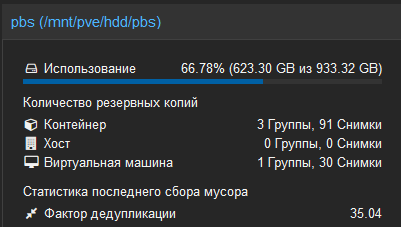

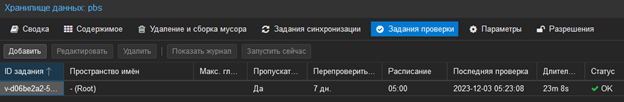

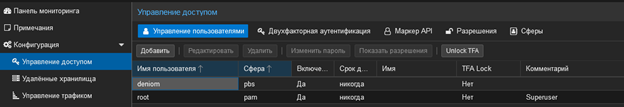

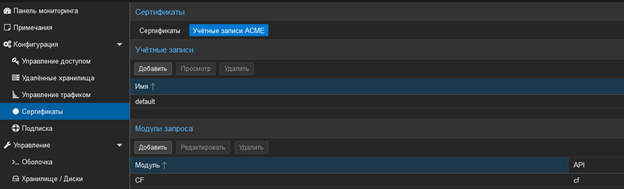

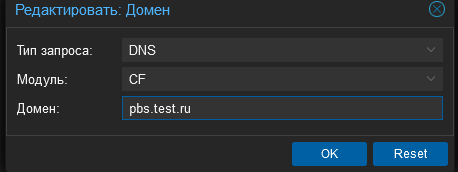

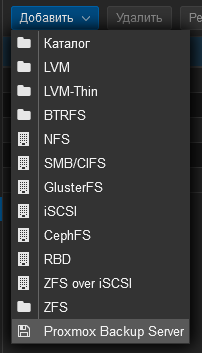

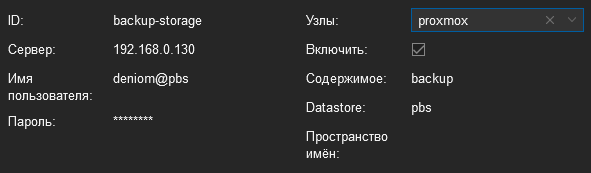

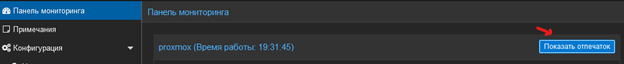

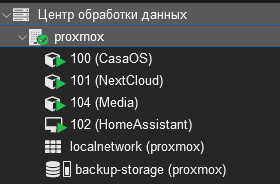

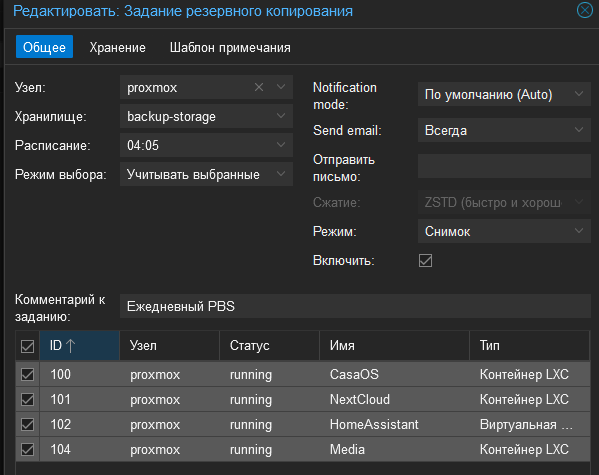

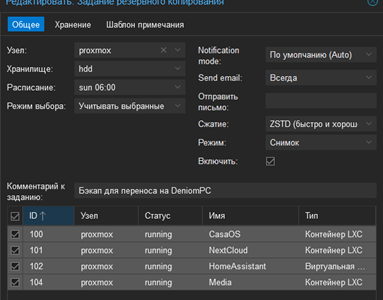

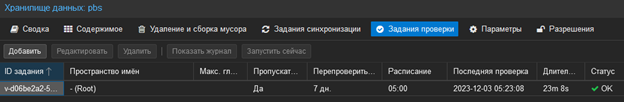

Вступление, или от простых бэкапов к отдельной системе Proxmox VE имеет встроенную поддержку создания резервных копий и снимков виртуальных машин, однако базовая реализация подвержена определенным ограничениям. Одной из таких проблем, с которой я столкнулся, является следующая: В моей схеме домашней инфраструктуры резервные копии виртуальных машин создавались каждую ночь в 4 часа утра. Полученные архивы сохранялись на жестком диске, подключенном к тому же мини-ПК. Это позволяло хранить до 7 копий виртуальных машин на диске, что было приемлемо, пока я не развернул отдельный контейнер с Nextcloud. Для меня важным стало резервное копирование жесткого диска, на котором хранятся пользовательские файлы Nextcloud. Это привело к увеличению суммарного размера ежедневной резервной копии с 5 ГБ до 30 ГБ и более. Такая ситуация оказалась неприятной и требовала поиска решения. Кроме того, я передавал полученные резервные копии из Nextcloud на основной компьютер для дополнительного резервного копирования, так как я не хотел рисковать потерей данных в случае отказа жесткого диска. Однако передача такого объема данных ежедневно по сети вызывала определенные неудобства, особенно учитывая тенденцию к увеличению объема данных. Попытка обсудить эту проблему в профильных чатах привела меня к изучению нового инструмента - Proxmox Backup Server (PBS). Зачем это все и что нам это дает? Основное отличие PBS заключается в том, что он не хранит полные копии бэкапов, а осуществляет запись только изменений в файлах. Этот процесс часто описывается термином 'инкрементальное резервное копирование' или 'дифференциальное резервное копирование'. Также имеется возможность настройки синхронизации с удаленным хранилищем, используя NFS. PBS автоматически проверяет целостность бэкапов, предоставляя также ряд других полезных функций. В моем случае, я хранил бэкапы за 3 дня (после добавления Nextcloud пришлось сократить историю с 7 до 3 дней), что в сумме занимало около 90-110 Гб на жестких дисках сервера и основного компьютера. Размер каждой виртуальной машины в архиве составлял от 5 до 10 Гб, а Nextcloud занимал около 20 Гб. После перехода на использование PBS, я теперь храню 30 резервных копий каждой виртуальной машины, занимающих примерно 65 Гб. Стоит отметить, что эти значения ситуативны и зависят от степени изменений данных. Если в вашем случае много изменений в больших файлах, то и объемы будут увеличиваться соответственно. Например, если вы решите создавать резервные копии фильмов (хотя зачем это нужно - другой вопрос). Фактически, PBS создает полную копию на первом этапе, а затем сохраняет только изменения по сравнению с предыдущей версией, что позволяет создавать некую 'машина времени' для данных. Особенности использования, или не все так радужно как хотелось бы... В отличие от бэкапов, создаваемых в виде архива, в данном случае мы получаем служебные файлы, которые кроме Proxmox никто прочитать не сможет. Это может быть серьезной проблемой, если надо вручную что-то вытащить, но всегда можно открыть и скачать архив через веб-интерфейс сервиса. Также для душевного спокойствия я оставил формирование классических бэкапов Proxmox в архив, но только раз в неделю, которые Nextcloud перекладывает на основной компьютер, а я уже руками забираю на внешний жесткий диск. Еще одной проблемой является то, что PBS не может делать синхронизацию через Samba для переноса бэкапов на тот же компьютер под Windows. Сам PBS поддерживает только NFS, который Microsoft не предоставляет на не серверных версиях Windows. Перенести файлы в ручном режиме или через WebDAV тоже не особо поможет, так как они являются скрытыми и частично зашифрованными. Для решения этой проблемы я испробовал много разных способов: от создания NFS сторонним софтом и в WSL до запуска отдельной виртуальной машины. Но самым оптимальным у меня получилось решение по запуску через Docker, о котором я расскажу отдельно. Также сам PBS можно поставить несколькими способами. Рекомендуемым вариантом является развертывание отдельной машины с образом ISO PBS, альтернативой может быть установка в Debian как пакет. Не рекомендуемым, но допустимым является установка в PVE, не рекомендуется из-за того, что данные могут быть потеряны, если возникнут проблемы с хостом. Еще один не очевидный, не заявленный и точно не рекомендуемый (но кого это остановит ) способ - это установка как Docker-контейнер. Основная часть, или хватит лирики В моем случае у меня был мини-ПК с жестким диском, на котором хранились бэкапы, так что вариант с установкой в PVE мне показался достаточно оптимальным, так как не требовал отдельной железки и вообще это домашний тестовый стенд (ака подопытный кролик). С этим делом все достаточно просто, можем обратиться к официальной инструкции: [https://pbs.proxmox.com/docs/installation.html#install-proxmox-backup-server-on-proxmox-ve] Но я вынес сюда основные шаги, на самом деле их будет всего 2. Подключаемся по SSH к хосту Proxmox и приступаем. 1. Добавляем репозиторий с PBS в источники для PVE nano /etc/apt/sources.list И добавляем запись deb http://download.proxmox.com/debian/pbs bookworm pbs-no-subscription Внимание!!! Я предполагаю, что лишние репозитории у вас были заранее выключены и используется бесплатная версия. Для этого можно воспользоваться скриптом для настройки Proxmox (применять после чистой установки, иначе на свой страх может ломать источники и бог знает что еще) bash -c "$(wget -qLO - https://github.com/tteck/Proxmox/raw/main/misc/post-pve-install.sh)" Все скрипты: [https://tteck.github.io/Proxmox/] 2. Обновляем список пакетов и устанавливаем PBS apt update apt install proxmox-backup-server Собственно на этом все, у нас есть PBS на нашем основном хосте, заходим на него по адресу: [https://<ip-or-dns-name>:8007] Нас встречает стандартный интерфейс proxmox и полное непонимание что с этим всем делать, но где наши не пропадали велики методом тыка идем в раздел хранилище данных, и создаем новое хранилище данных. Фактически мы указываем путь, где будут лежать наши файлы бэкапов в разбиении на служебные файлы proxmox. После инициализации получаем обзорную информацию о нашем диске, тут можно оценить и прогноз по заполнению и фактор дедукции (то на сколько наши бэкапы повторяют себя) а также посмотреть статусы по регламентным заданиям. Тут же настроим задание проверки резервных копий на целостность. Следующим шагом необходимо настроить права для работы с полученным хранилищем. Идем в радел управление доступом и создаем нового пользователя: На вкладке разрешения настраиваем доступ к самому хранилищу, я в общем виде выдаю права администратора так как не вижу угрозы для своей системы, но данный вопрос можно подробно почитать в справке. Добавляем примерно так: В итоге должно получиться В интерфейсе хранилища данных так же должны быть такие записи !!! Внимание !!! Дополнительный раздел и не обязательные действия. Если у вас есть свой домен и отдельный пунктик на предупреждения браузера о само подписанных сертификатах можно выпустить новый сертификат с помощью dns chelenge если или закинуть свой сертификат. Это надо если не используете прокси сервер или для обеспечения стабильности когда npm лежит. Данная инструкция так же актуальна для Proxmox VE. Переходим в раздел сертификаты, вкладка учетные записи: Создаем новую учетную запись, и новую запись модуля. На вкладке сертификаты добавляем новую запись ACME и выполняем запрос сертификата Данные действия обязательно делать до подключения так как получение сертификата изменяет подпись вашего сервера PBS. Подключение PBS к proxmox VE, или когда это уже закончиться… Заходим в веб интерфейс proxmox VE, идем в раздел хранилаща и добавляем наш PBS В моем случае настройки выглядят так: Сервер указываем IP вашего хоста, отдельно обращаю внимание что соединение происходит по 8007 порту, отдельностоит обратить внимание при настройки прокси сервера. Настройки по хранению резервных копий делать не надо за это будет отвечать сам PBS. Отдельно надо отметить поле отпечаток, он нужен для установки ssl соединения между нашими системами. Что бы его получить возвращаемся в интерфейс PBS и на вкладке понель мониторинга нажимаем показать отпечаток. После завершения настройки у вас появиться новое хранилище в вашем интерфейсе Proxmox VE Настроим резервное копирование. Переходим в раздел корня – «Резервное копирование» и создаем новую запись. Дополнительных настроек не надо. Отдельно надо отметить, что вариант сжатия мы не выбираем за это, отвечает сам PBS. Так же не маловажная особенность по режимам, которая, может быть, и при обычном создании бэкапов, но при использовании PBS она возникает гарантировано. Если выбирать режим «Снимок», которые делает бэкапы без остановки виртуальных машин, в процессе бэкапа создается копия виртуальной машины со всеми подключенными (и указанными для бэкапа) дисками. Эта копия создается в директории /var основного хоста, и если в процессе не хватит места, то возникнет ошибка типа такой: ERROR: Backup of VM 101 failed - command 'rsync --stats -h -X -A --numeric-ids -aH --delete --no-whole-file --sparse --one-file-system --relative '--exclude=/tmp/?*' '--exclude=/var/tmp/?*' '--exclude=/var/run/?*.pid' /proc/1632/root//./ /proc/1632/root//./mnt/nextcloud /var/tmp/vzdumptmp128654_101' failed: exit code 11 Для исправления ее есть несколько способов я использовал два: 1. Та виртуалка которая не помещается во временные файлы бэкапиться в режиме «Остановка» 2. Увеличение пространства lvm root для того что бы поместились данные. При этом не надо что бы туда влазил весь выделенный диск, достаточно что бы в свободное пространство помещались все сохраняемые данные. Так же есть способы с переопределением директории /var но данные методы мне показались запутанными и пока для моей ситуации не востребованы. Так же у меня осталось регламентное копирование в архивы раз в неделю для переноса на внешний диск как я и писал в начале статьи. Фактически на этом настройка PBS закончена, вы можете создавать более правильные и оптимальные бэкапы. В отдельном материале я расскажу как настроить синхронизацию PBS с компьютером для создание дополнительного хранилища бэкапов. Всем спасибо за внимание, желаю вам удачных бэкапов которы не когда вам не понадобяться.

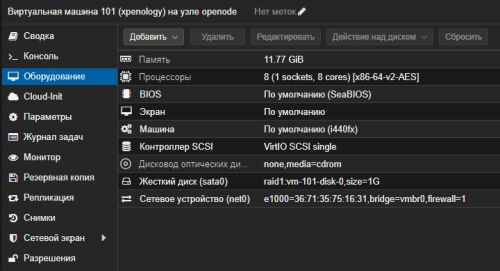

-

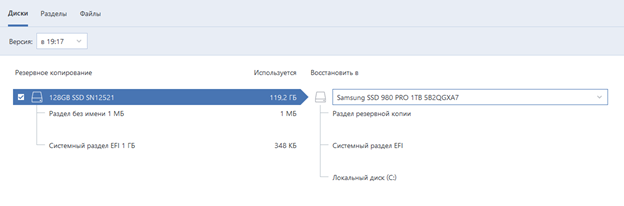

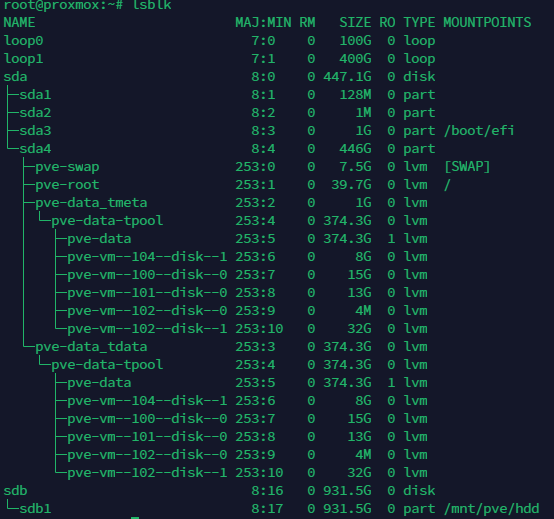

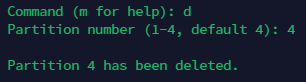

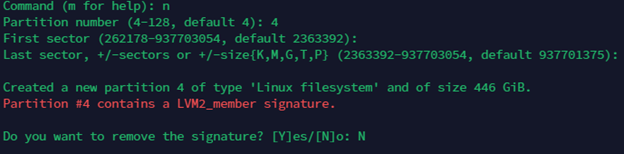

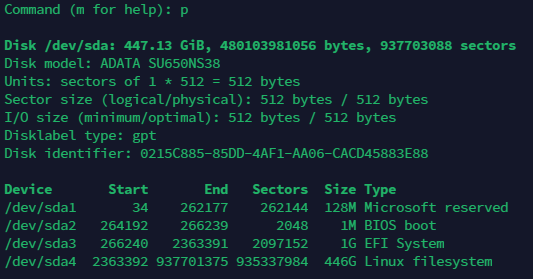

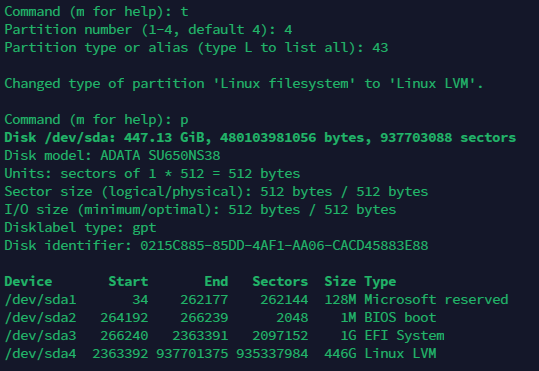

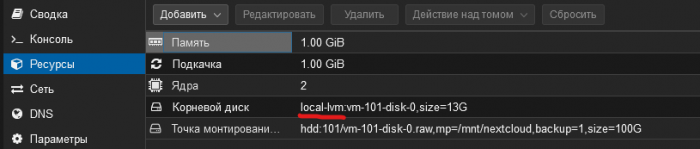

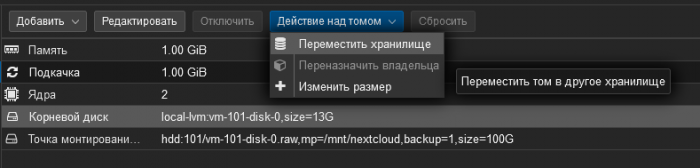

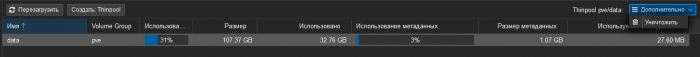

В процессе переноса системы proxmox на новый SSD большего объема я оставлю здесь краткое пошаговое руководство, которое может оказаться полезным кому-то: Для переноса данных было использовано приложение Acronis True Image на операционной системе Windows. !!! Внимание скриншоты сделаны пост фактум и добавлены только для общего понимания процесса, вывод будет похожим но в моем случае распределение уже было выполнено !!! 1.1. Установлен старый SSD диск в основной компьютер с Windows. 1.2. Создана резервная копия файлов со старого диска (необходимо включить все разделы, так как Windows не видит файлы настроек: Дополнительно - Режим создания - Архивирование в посекторном режиме). 1.3. Установлен новый SSD в компьютер и запущено восстановление диска с параметрами: Дополнительно - Восстановление по секторам. 2. Установленный SSD диск был установлен в сервер, система загрузилась, используя новый SSD. Следующим шагом было расширение полученного диска для использования всего доступного пространства. 2.1. Определяем, в каком диске находятся наши данные proxmox, используя команду: lsblk В данном случае, это был диск sda и раздел sda4. 2.2. Производим расширение раздела: fdisk /dev/sda Просматриваем текущую структуру разделов с помощью команды: p. Запоминаем начальный сектор раздела sda4, так как новый раздел должен начинаться с этого же сектора. Удаляем раздел с помощью команды: d, указываем раздел: 4. Создаем новый раздел с помощью команды: n. Начало нового раздела должно совпадать с начальным значением раздела, которое мы запомнили ранее. По умолчанию предлагается использовать все доступное пространство для нового раздела, с чем мы соглашаемся. На вопрос о удалении метки отвечаем "N", но метка все равно будет повреждена. Поэтому исправляем тип раздела 4 на Linux Filesystem с помощью команды: t с указанием типа 43. Сохраняем изменения с помощью команды: w, для выхода без сохранения используем: q. Перезагружаем хост: reboot Выполняем команду: pvresize /dev/sda4 После этой операции размер раздела sda4 должен увеличиться. Так же в веб интерфейсе proxmox мы должны увидеть похожу картину (!!! Обратите внимание скриншот сохранен после перераспределения в случае настройки на данном шаге у вас будет занято меньше пространства) После этого увеличиваем размер директории local-lvm которая используется для наших виртуальных машин. Обратите внимание pve это имя хоста оно может отличаться, его можно увидеть в том числе при выводе lsblk. lvextend -L +350G /dev/pve/data Увеличили размер на 350Gb и видим изменение в интерфейсе Все можем использовать расширенное пространство для развертывания новых виртуальных машин. Иногда бывает надо увеличить не только директорию local-lvm но и основную директорию local (она же root) которую использует proxmox для хранения временных файлов. В такой ситуации команда будет выглядеть вот так: lvextend -L +10G /dev/pve/root Обязательно после изменения root директории необходимо выполнить реструктуризацию файловой системы командой resize2fs /dev/pve/root Еще один вариант задачи когда мы хотим сократить размер пула local-lvm, в таком случае безболезнено не получиться изменить. Нам необходимо освободить пул от данных. Для этого либо надо удалить все виртуальные машины либо мигрировать их на другой диск или пул. Для этого останавливаем виртуальную машину, и нам открывается доступ для изменения диска. Обязательно удаляем исходный (его потом можно удалить в этом же интерфейсе после миграции) Когда миграция закончена переходим в управления пулами. Выбираем нужный пул и удаляем его. После удаления у нас высвободиться пространство в LVM которое можно будет перераспределить. Для создания нового пула перейдем в консоль и вводим команды: lvcreate -L100G -ndata pve lvconvert --type thin-pool --poolmetadatasize 1G pve/data В данном примере создаем пулл на 100G, для него обязательно инициируем метаданные из расчета 1% от пула не менее 1G. Возвращаемся в веб морду и переходим в раздел хранилище. Где подключаем полученный пулл к proxmox После этого можно выполнить обратную миграцию всех дисков виртуальных машин, или восстановить их из резервной копии. Всем спасибо за внимание, надеюсь данный материал поможет. Большая часть команд взята из материала: https://help.univention.com/t/how-to-extend-disk-space/10647 и применена в современных реалиях proxmox 8.1 с помощью чата сообщества proxmox.

- 1 ответ

-

- 1

-

-

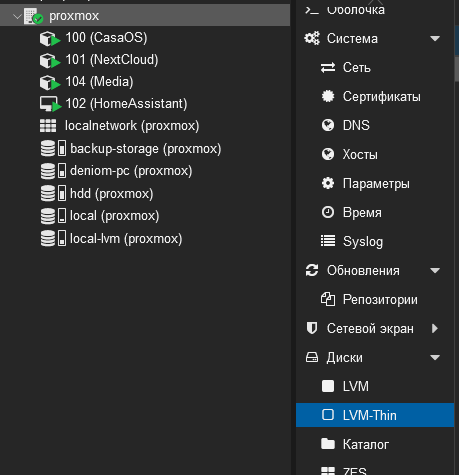

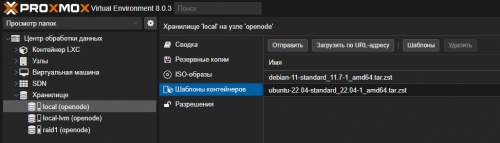

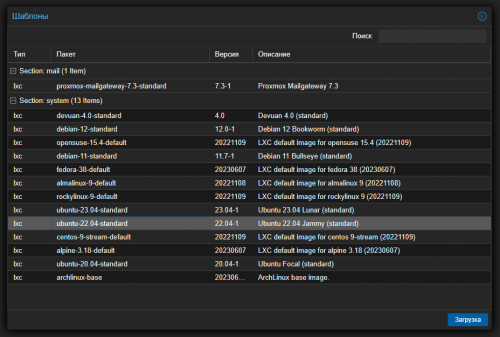

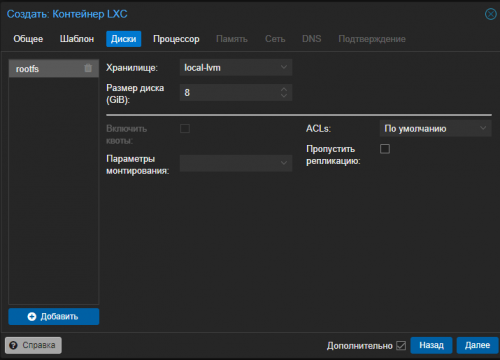

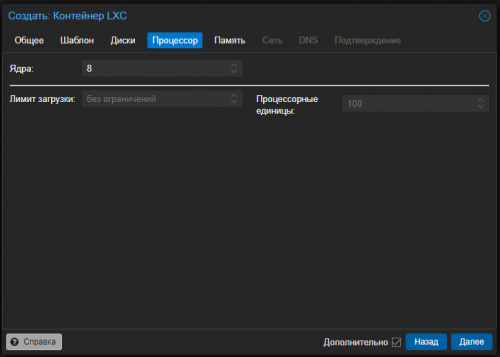

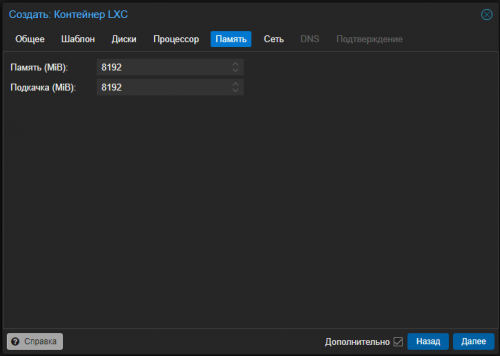

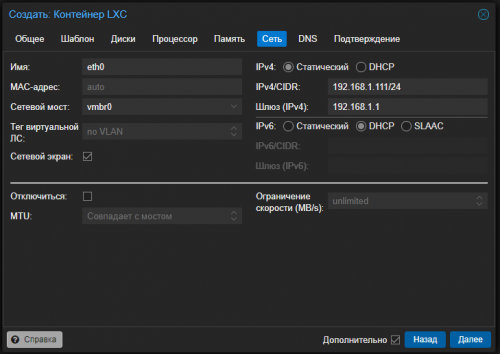

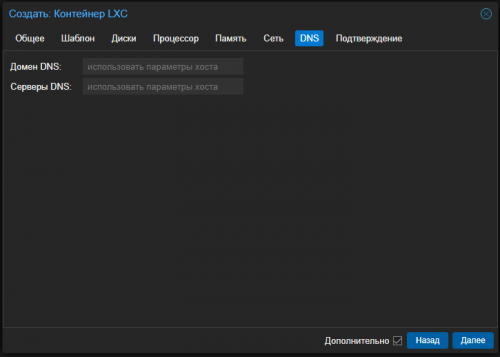

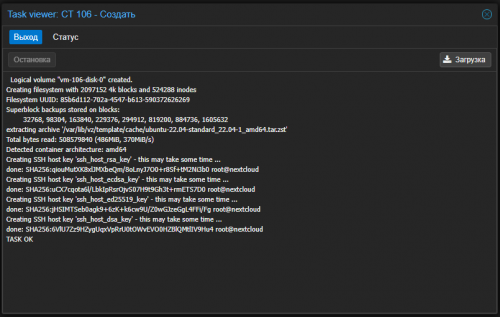

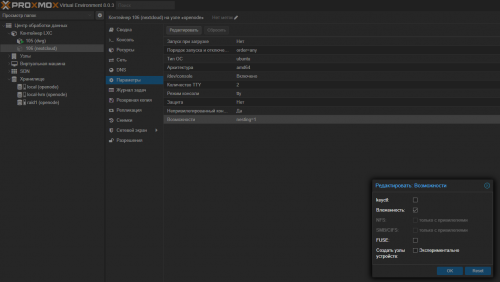

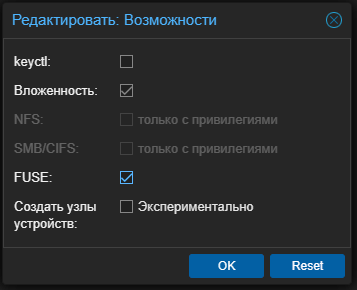

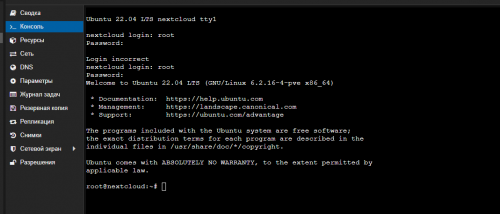

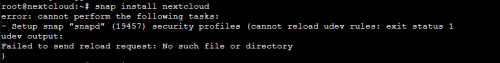

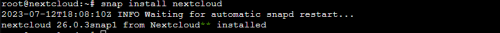

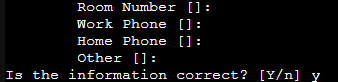

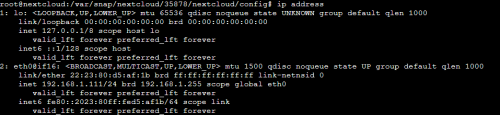

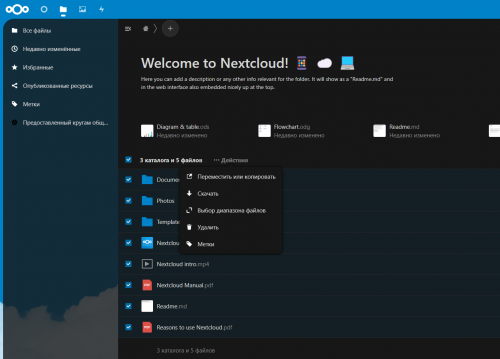

Всем привет. Иду дальше по параллельным настройкам. Контейнеров и разбираюсь понемногу в PM. ProxMox позволяет создавать не только виртуальные машины, но и контейнеры. Причем контейнеры создаются исходя из шаблона операционных систем. Тоесть поднимается что то "минимальное" из всей операционки. Это компактнее с позиции экономии места. И это полезно для контроля ресурсов. Конечно, контейнер можно засунуть и в Docker - но управление через ProxMox будет не полноценным. Хотя можно поставить конечно и Portainer (с ним мы разберемся чуть позже) Установка NextCloud на ProxMox 8 VE 1. Для создания контейнера нам нужно создать шаблон. 1.1. Выбираем Local в нашем сервере. 1.2. Выбираем Шаблоны контейнеров 1.3. Жмём "Шаблоны" 1.4. В перечне выбираем Ubuntu 22.04 и жмём Загрузка 2. После загрузки у нас он появится в списке (см. первый скриншот) 3. Далее жмём в самом верху: 4. Появилось окно: 4.1. Заполняем Имя хоста и Пароль (Имя хоста мы особо нигде использовать не будем, поэтому указываете чтобы было понятно вам. А пароль вам нужен будет для авторизации в консоле контейнера.) 4.2. Идём Далее 4.3. Выбираем наш шаблон ubuntu 22.04 4.3. Места выделяем 8гб (хватит под систему) 4.4. Далее выбираем в Процессоре - Ядра. Я советую не меньше 4 ядер (это будет полезно при обработке фотографий). У меня запас есть, поэтому я выделю 8 ядер. 4.5. Приложение у нас будет достаточно требовательным к ресурсом. У меня 64Гб памяти на сервере (и планирую его расширить потом до 128), поэтому я выделяю под NextCloud 8Гб. Вам же могу порекомендовать не менее 4Гб выделить и столько же Подкачки (SWAP): 4.6. Задаем статический IP или используем DHCP сервер: 4.7. Вкладку DNS оставляем по умолчанию. И создаем контейнер. 4.8. Получаем TASK Ok. 5. Выбираем наш Контейнер, заходим в Параметры и выбираем Возможности =- Редактировать 5.1. Здесь нам нужно включить FUSE и жмём ОК FUSE (англ. filesystem in userspace — «файловая система в пользовательском пространстве») — свободный модуль для ядер Unix-подобных операционных систем, позволяет разработчикам создавать новые типы файловых систем, доступные для монтирования пользователями без привилегий (прежде всего — виртуальных файловых систем) 6. Запускаем контейнер. И авторизовываемся 7. В консоли вводим команду apt update && apt upgrade -y 8. Теперь, когда CT обновлен, пришло время установить программное обеспечение, которое мы будем использовать для установки пакетов snap моментальных снимков. Для этого используйте команду: apt install squashfuse snapd -y 8. Используя пакетный менеджер SNAP мы будем устанавливать NextCloud: (Если с первого раза не запустилось, повторите команду снова) snap install nextcloud Первый запуск был такой: Второй запуск: 8.1. Теперь нам нужно добавить пользователя в систему (я рекомендую) 8.2. Пишем: adduser <username> 8.3. Система предложит ввести пароль два раза. Вводим. Также вводим доп информацию по желанию и в конце выбираем Y - подтверждая что все ок. 8.4. Добавляем пользователя в sudo группу: adduser <username> sudo 9.1. Создадим администратора NextCloud (Username и Пароль Я вводил того же пользователя, которого я создал): nextcloud.manual-install <username> <password> 9.2. Теперь нам нужно сообщить NextCloud, что мы можем доверять конкретному IP-адресу: (я добавил IP адрес нашего сервера - 192.168.1.111) Смотрим его командой: ip address Убеждаемся что контейнер доступен по нему: nextcloud.occ config:system:set trusted_domains 1 --value=<ip address> 9.3. Можно добавить домен привязанный к вашему адресу. (привязать домен вы можете используя сервисы для DDNS, или имея белый адрес от провайдера - привязать просто к нему свой) : nextcloud.occ config:system:set trusted_domains 1 --value=example.com И то и то использовать не получится. Поэтому либо внутренний адрес, либо домен. Переходим в файлы, и тут я рекомендую удалить все заготовки: Переходим в параметры сервера: И настраиваем все по своему желанию )) Удачи!

-

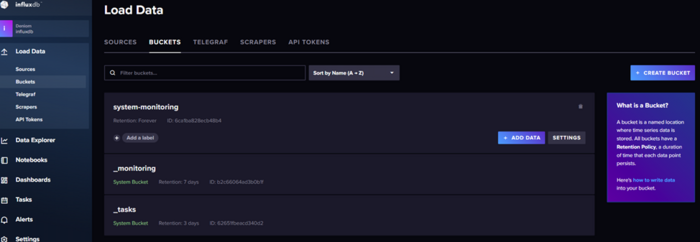

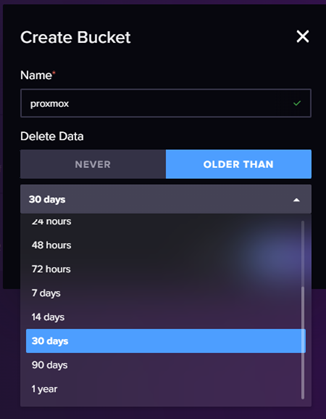

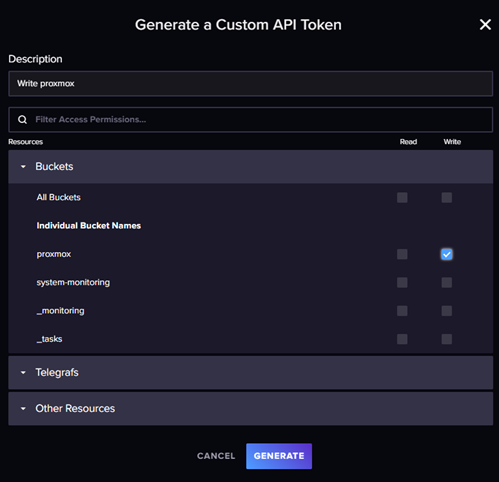

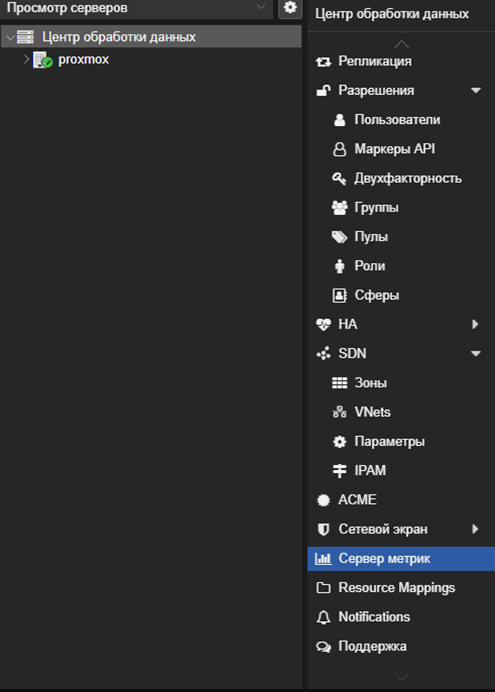

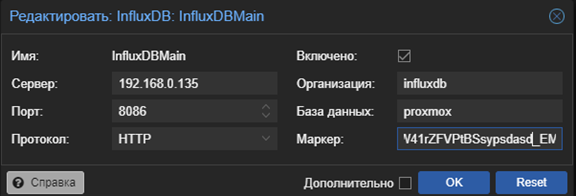

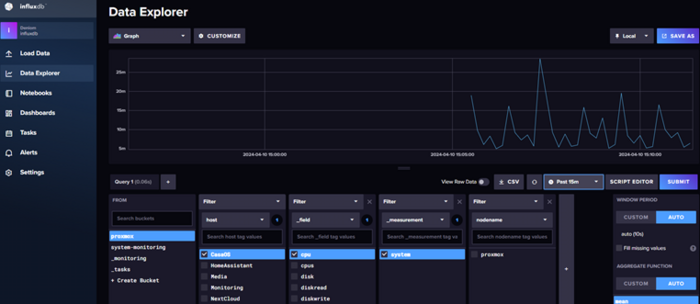

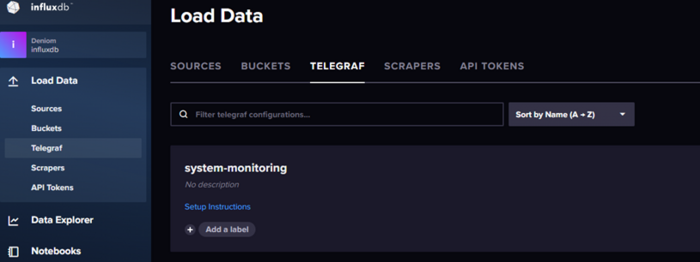

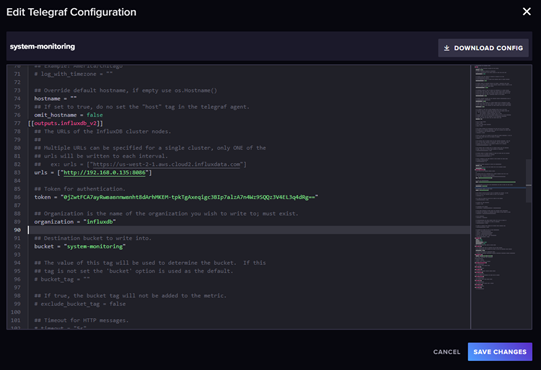

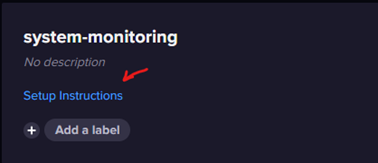

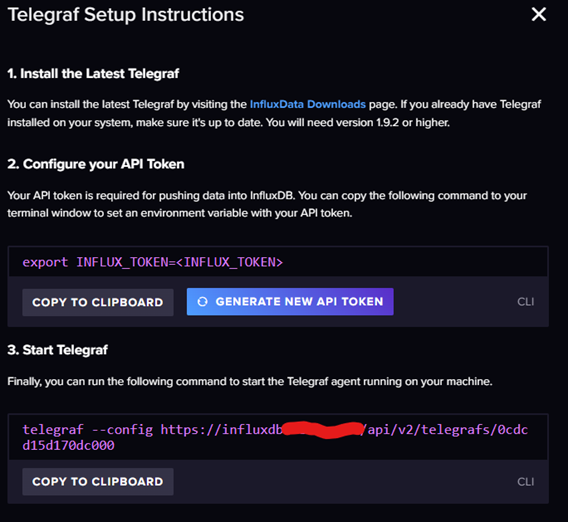

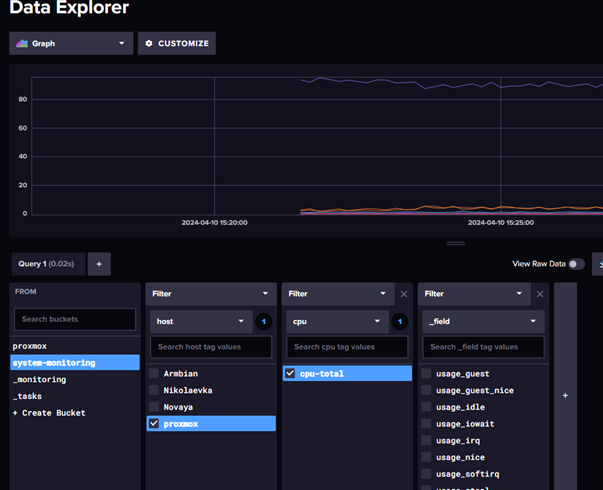

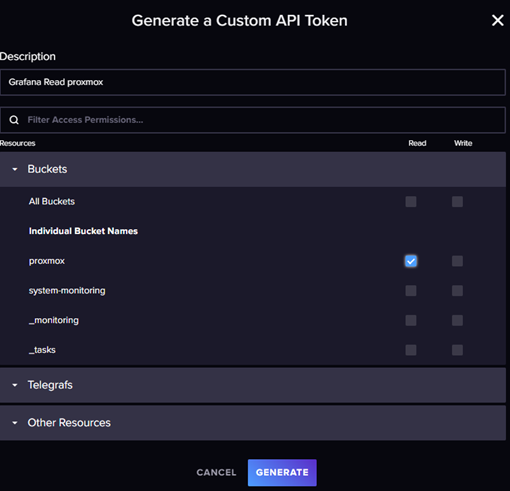

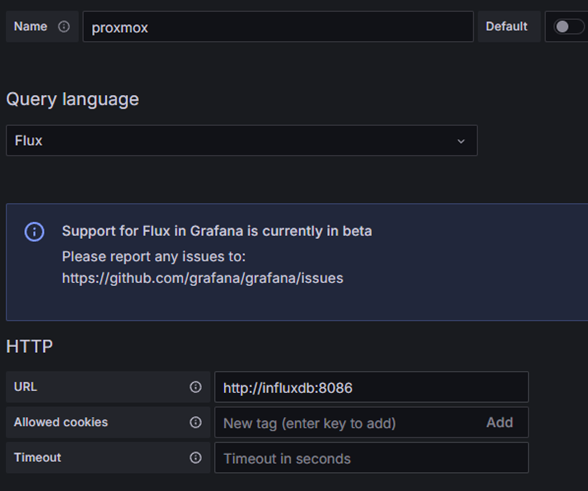

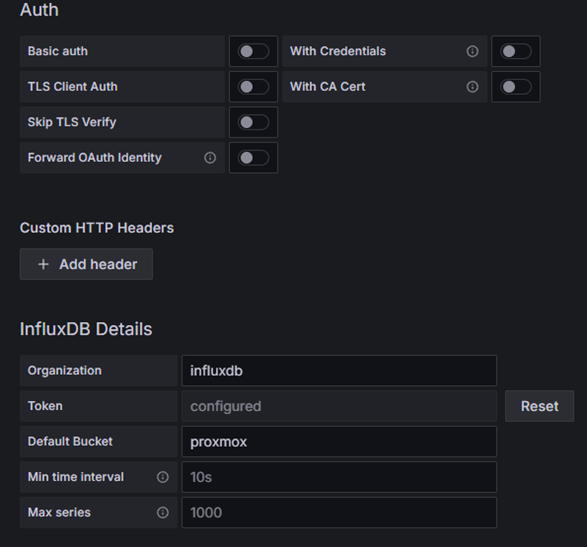

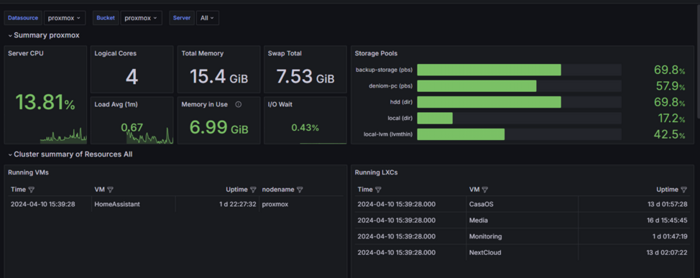

Первичную настройку я разбирал уже в первой части так что в этой части будет меньше моментов по настройки самой Grafana и InfluxDB. Первая часть. Вступление, или варианты решения Для мониторинга состояния proxmox у нас есть несколько способов решения задачи. Использовать сам proxmox для отправки данных в influxdb Использовать telegraf для сбора данных через API proxmox и отправки их в influxdb Использовать telegraf для сбора данных хоста proxmox Фактически первые два варианта равнозначны и используют API proxmox которого достаточно для большинства задач, но в нем нет одного важного для меня показателя температура процессора. Подробнее про API proxmox можете почитать тут: https://pve.proxmox.com/wiki/Proxmox_VE_API Обращаться по API из telegraf в моем случае я тоже не вижу смысла так как вся система у меня находится в одной локации, это было бы оправдано если нам необходимо контролировать разрыв связи или собирать данные сразу с нескольких источник. Поэтому я буду использовать комбинацию первого и третьего варианта. Настройка отправки данных из proxmox Для мониторинга состояния proxmox VE нам необходимо создать новую корзину для данных в influxDB для этого заходим в influxDB в раздел Load Data -> Bucket При создании есть возможность выставить как долго хранить данные, я выбрал вариант never так как не вижу проблем в разрастании базы на текущий момент. Теперь необходимо создать токен доступа для корзины, который будет давать права на запись в базу. Переходим в меню управления API токенами и создаем новый custom token Даем права на запись для созданной корзины данных. Сохраняем себе полученный токен Внимание кнопка копирования токена может не сработать, проверяйте перед закрытием. Переходим в proxmox, нас интересует раздел сервер метрик. Создаем новую запись influxDB. Указываем в поле база данных имя корзины, а в поле маркер полученный токен записи. Проверяем что в ifluxBD появились данные. Теперь нам надо еще собирать данные о температуре сервера proxmox не зависимо от api proxmox. Я для этого буду использовать шаблон созданный в прошлый раз для system-monitoring, он доступен в разделе telegraf. Так как это хост система в данном случае я буду использовать пакетный вариант telegraf Подключаемся по ssh или через оболчку proxmox в браузере и устанавливаем пакет. Подробно все расписано в документации по установке тут: https://docs.influxdata.com/telegraf/v1/install/ Обратите внимание что, работая в оболочке proxmox у нас не будет sudo если работать под root Приведу команды установки из-под root пользователя: curl -s https://repos.influxdata.com/influxdata-archive_compat.key > influxdata-archive_compat.key echo '393e8779c89ac8d958f81f942f9ad7fb82a25e133faddaf92e15b16e6ac9ce4c influxdata-archive_compat.key' | sha256sum -c && cat influxdata-archive_compat.key | gpg --dearmor | tee /etc/apt/trusted.gpg.d/influxdata-archive_compat.gpg > /dev/null echo 'deb [signed-by=/etc/apt/trusted.gpg.d/influxdata-archive_compat.gpg] https://repos.influxdata.com/debian stable main' | tee /etc/apt/sources.list.d/influxdata.list apt-get update && apt-get install telegraf Актуальные команды всегда будут доступны в официальной документации, просто удалите sudo из команд. Дальше нам необходимо получить нашу конфигурацию system-monitoring, для этого переходим в шаблоны telegraf открываем наш шаблон и копируем от туда токен доступа Закрываем это окно сам файл нам не понадобится, нам нужна инструкция по установке. Возвращаемся в оболочку proxmox и выполняем две команды как расписано в инструкции заменив <InfluxToken> на скопированный ранее токен. Обязательно надо передать ключ сначала отдельной командой для получения доступа к самому шаблону настроек. Но в принципе можно и просто скачать файл и отдать его telegraf как это было с docker вариантом. Проверяем что данные поступают в корзину и Grafana Обратите внимание что Grafana дополнительно настраивать для данной корзины не надо, а для корзины proxmox надо. Для этого переходим в управления токенами API и создаем токен на чтение корзины proxmox для Grafana. Подробно настройку Grafa я разбирал в прошлой публикации, тут приведу только результат настроек. Пример панели proxmox в Grafana Я использовал шаблон: https://grafana.com/grafana/dashboards/15356-proxmox-cluster-flux/ Вместо заключения Спасибо за внимание, в следующих публикациях я разберу так же способы мониторинга состояния роутеров keenetic и openwrt.

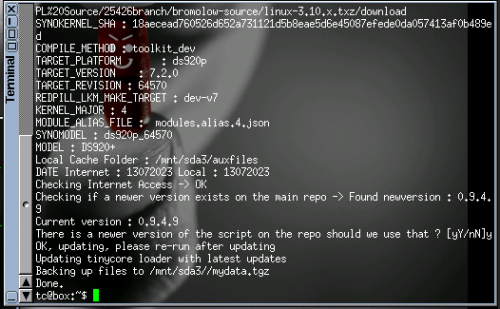

-

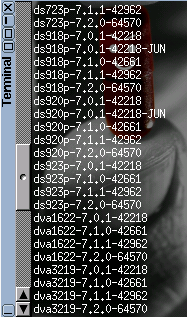

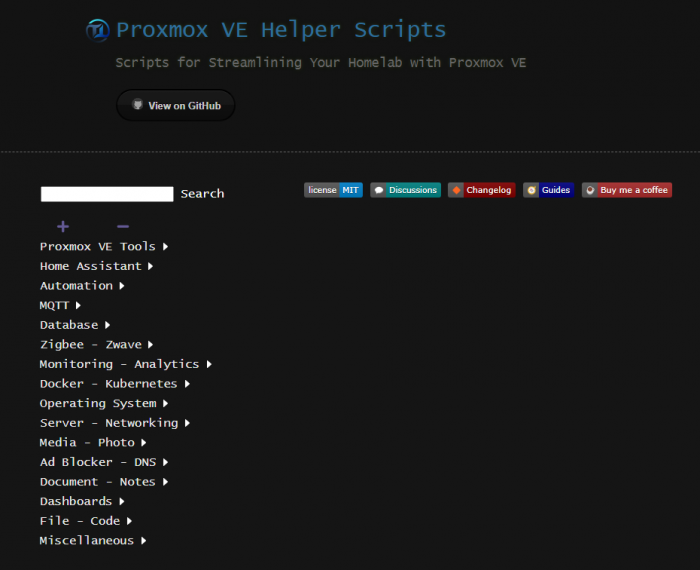

Введение Свежий выпуск Proxmox VE 8.0, который вышел 22 июня 2023 года, основан на Debian Bookworm и имеет ряд новых функций, таких как использование ядра Linux 6.2 по умолчанию. Proxmox VE 8.0 имеет новый текстовый интерфейс установки с возвратом к предыдущей версии, который может быть очень полезен для работы с проблемами новых процессоров. О том какой сервер я собрал дома, я описывал в серии других тем: Что будет рассмотрено в этой статье (в двух частях) В этом руководстве рассматривается установка Proxmox на физический сервер, а затем развертывание виртуальной машины Home Assistant OS (HAOS). Более конкретно, я рассматриваю следующие аспекты: Часть 1: 1. Почему лучше использовать Proxmox VE для Home Assistant? 2. Рекомендации по хранению данных в Proxmox. 3. Создание загрузочного USB-накопителя для Proxmox. 4. Установка Proxmox VE 8. 5. Конфигурация Proxmox после установки. 6. Обновление микрокода Intel (по желанию). Часть 2: 7. Установка виртуальной машины Home Assistant OS (HAOS). 8. Настройка статического IP-адреса (рекомендуется). 9. Обход блокировки DNS через HTTPS. 10. Передача USB в HAOS (по желанию). 11. Оптимизация мощности процессора (по желанию). 12. Проверка мониторинга SMART (по желанию). 13. Включение VLAN в Proxmox (по желанию). 14. Репозиторий tteck. 1. Почему лучше использовать Proxmox VE для Home Assistant? Во-первых, почему бы не запустить Home Assistant OS в виде виртуальной машины на Proxmox VE 8? Дело в том, что Home Assistant обычно не требует больших ресурсов, и даже старые мини-ПК, купленные несколько лет назад, могут иметь много свободных вычислительных ресурсов, которые можно использовать для запуска других сервисов. Proxmox VE - это бесплатный гипервизор на основе KVM с удобным пользовательским интерфейсом для управления, который довольно прост в использовании. Он позволяет запускать HAOS в виде виртуальной машины, а также запускать другие виртуальные машины или контейнеры LXC на одном и том же оборудовании. Если вы новичок в Home Assistant, не являетесь экспертом в этой области и просто хотите надежное и простое в использовании "устройство", тогда не стоит выбирать путь через Proxmox VE. Просто найдите дешевый использованный мини/ультра-мини ПК и установите Home Assistant OS "напрямую" на него и закончите с этим. Но если вы знаете, что хотите использовать HAOS в виде виртуальной машины и, возможно, в будущем использовать контейнеры LXC, то Proxmox VE - отличный (и бесплатный) вариант. Несмотря на то, что Home Assistant может выполнять резервное копирование, возможность создания снимка всей виртуальной машины HAOS на уровне гипервизора может быть полезной для отката после неудачных обновлений или ошибок. В данном руководстве используются потрясающие скрипты от tteck для Proxmox. Это делает процесс установки очень простым, позволяет использовать последнюю версию HAOS и обеспечивает возможность настройки через графический интерфейс. Он обновил свои скрипты для совместимости с Proxmox VE 8.0. 2. Рекомендации по хранению данных в Proxmox Рекомендации по хранению данных в Proxmox зависят от конкретных требований и условий использования. Вот несколько рекомендаций для домашней среды: 1. Используйте один SSD/NVMe диск (например, M.2) в вашем сервере Proxmox. Убедитесь, что его емкости достаточно для будущего расширения. 2. Используйте файловую систему EXT4 (по умолчанию) с LVM-thin (также по умолчанию) в Proxmox. 3. Используйте встроенное средство резервного копирования Proxmox для ежедневного создания резервных копий всех виртуальных машин и контейнеров LXC на вашем NAS. 4. Используйте дополнение Google Drive Backup в Home Assistant для ежедневного создания резервных копий в облаке. 5. Настройте Home Assistant 2023.6 (и более поздние версии) для создания резервных копий напрямую на ваш NAS. 6. Не пытайтесь подключать сетевое хранилище NAS непосредственно к хосту Proxmox и использовать его для хранения виртуальных машин или контейнеров LXC. Всегда создавайте ваши виртуальные машины или контейнеры LXC на локальном хранилище Proxmox, чтобы избежать возможных проблем. Для производственных сред можно рассмотреть более сложные конфигурации хранения данных, такие как использование ZFS, зеркалирование ZFS и множественные физические устройства хранения. Однако в домашней среде, если вы не являетесь экспертом в этой области, рекомендуется простая конфигурация с одним диском и надежными резервными копиями. Это будет более чем достаточно для подавляющего большинства пользователей Home Assistant. 3. Создание загрузочного USB-накопителя для Proxmox. Для начала установки Proxmox нам нужно создать загрузочный диск USB. Для этого лучше всего подходит Balena Etcher (Mac/PC/Linux). Скачать можно по ссылке: https://www.balena.io/etcher 1. Качаем последнюю версию Proxmox VE 8.0 ISO Installer 2. Качаем и устанавливаем Balena Etcher 3. Записываем наш образ на USB диск. (этот процесс я описывать не буду, там все на столько просто, что даже смешно) 4. Установка Proxmox VE 8. 1. Подключите клавиатуру и монитор к вашему серверу Proxmox/мини-ПК/NUC и т. д. 2. Выключите сервер и вставьте USB-накопитель с загрузочным образом. 3. Включите сервер и нажмите правильную клавишу для входа в настройки BIOS (это может отличаться в зависимости от производителя). 4. В зависимости от предыдущей операционной системы, возможно, потребуется внести некоторые изменения в настройки. Наименование этих настроек и их расположение в меню могут отличаться в зависимости от производителя BIOS. Проверьте следующие настройки: - Включите виртуализацию (может называться VT-x, AMD-V, SVM и т. д.). - Включите Intel VT-d или AMD IOMMU (готовность к использованию PCIe/GPU-проброса). - Оставьте включенным режим загрузки UEFI. - Включите автоматическое включение питания (это гарантирует, что хост будет включаться после перебоев в подаче питания). Примечание: Эта настройка может быть сложной для поиска, иметь неочевидные названия (например, установка состояния после G3 в состояние S0) или отсутствовать вовсе. Это зависит от производителя. 5. Измените порядок загрузки, чтобы USB-накопитель был первым в списке. 6. Сохраните настройки BIOS и перезагрузите систему. Если все прошло успешно, начнется установщик Proxmox VE 8.0. Дальнейшая установка через графический интерфейс, достаточно проста и интуитивно понятна. Но если графический интерфейс не работает на вашем процессоре, вы можете воспользоваться консольной версией. (картинки взяты из интернета, поэтому на значения в них не обращайте внимание, ориентируйтесь на свои параметры) 7. Выберите "Install Proxmox VE (Console)" с помощью стрелок. 8. Нажмите Enter на "I agree" для согласия с EULA (лицензионным соглашением). 9. Выберите целевой жесткий диск и нажмите Enter на "Next". Примечание: Не изменяйте файловую систему, если вы не знаете, что делаете и хотите использовать ZFS, Btrfs или xfs. По умолчанию используется EXT4 с LVM-thin, и мы будем использовать именно ее. 10. Выберите свою страну, часовой пояс и раскладку клавиатуры. 11. Введите надежный пароль и адрес электронной почты. 12. Выберите вашу управляющую интерфейс, имя хоста, IP-адрес, шлюз и DNS-сервер. Примечание 1: Если ваш сервер подключен к сети, он должен получить IP-адрес через DHCP и заполнить остальную информацию. Я настоятельно рекомендую использовать статический IP-адрес или создать резервацию DHCP для этого сервера. Вам не понадобится изменять IP-адрес в будущем. Примечание 2: Обдумайте имя хоста Proxmox, которое вы хотите использовать. ВЫ НЕ СМОЖЕТЕ изменить его позже, и это может вызвать серьезные (вероятно, неустранимые) проблемы с Proxmox. Я бы рекомендовал использовать что-то общее, например "proxmox". 13. Три раза проверьте всю информацию на экране "Summary" и убедитесь, что она верна, затем выберите "Install" для начала установки. 5. Конфигурация Proxmox после установки. Перед установкой Home Assistant и других контейнеров нам необходимо выполнить несколько задач по настройке. Во-первых, мы должны обновить Proxmox до последней версии пакетов. Обратите внимание, ЧТО ВЫ ОБЯЗАНЫ выполнить скрипт пост-конфигурации перед обновлением Proxmox или развертыванием HAOS. В противном случае вы, скорее всего, увидите ошибки 401 с платными репозиториями Proxmox, поскольку у вас (вероятно) нет платной лицензии Proxmox. Откройте браузер и перейдите по IP-адресу и порту 8006 (например, в моем случае это: https://192.168.1.230:8006/). Пройдите через все предупреждения браузера и все равно подключитесь. Войдите с помощью учетной записи root и пароля, выбранного вами в процессе установки. Примечание: Вы получите предупреждение о подписке. Мы исправим это сразу. Подтвердите предупреждение. 3. В левой панели щелкните по имени хоста вашего сервера Proxmox. 4. Щелкните по "Shell" / "Оболочка" в средней панели и вставьте следующую команду для запуска потрясающего скрипта пост-установки tteck: bash -c "$(wget -qLO - https://github.com/tteck/Proxmox/raw/main/misc/post-pve-install.sh)" 5. Скрипт tteck задаст вам ряд вопросов. Запустите скрипт и ответьте "Y" на все вопросы. Подождите несколько минут, пока все обновления устанавливаются. 6. Когда вам будет предложено перезагрузиться, нажмите Enter на "yes". 6. Обновление микрокода Intel (по желанию). Регулярно Intel выпускает новые микрокоды для своих процессоров. Это отличается от прошивки BIOS, поскольку микрокод Intel работает внутри процессора. Он может исправлять ошибки ЦПУ или вносить другие изменения, по мере необходимости. Если вы используете систему на базе процессора Intel, вы можете использовать следующий скрипт tteck для загрузки последнего микрокода Intel и его установки. Для применения микрокода потребуется перезагрузка системы. bash -c "$(wget -qLO - https://github.com/tteck/Proxmox/raw/main/misc/microcode.sh)" После перезагрузки Proxmox хоста вы можете выполнить следующую команду, чтобы узнать, активно ли какое-либо обновление микрокода. Не все ЦПУ требуют обновления микрокода, поэтому возможно, вы не увидите никаких указаний. journalctl -k --grep="microcode updated early to" Продолжение будет во второй части статьи. Но в текущей я хотел бы все таки оставить ссылку на набор самых полезных скриптов, каждый из которых я разберу в отдельной теме: Proxmox VE Helper Scripts | Scripts for Streamlining Your Homelab with Proxmox VE (tteck.github.io)

-

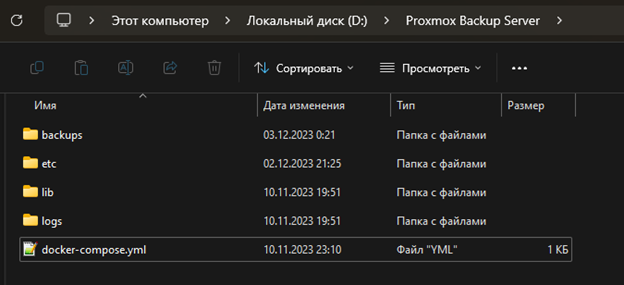

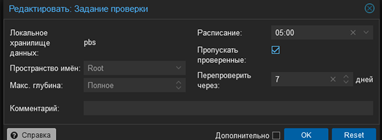

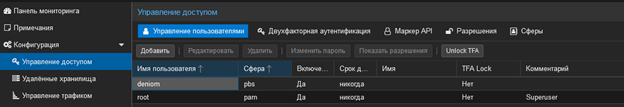

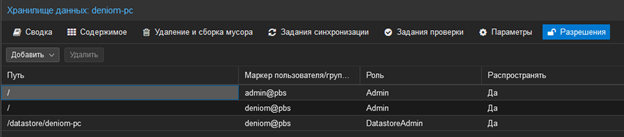

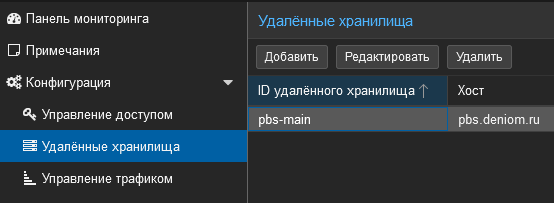

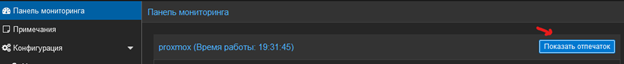

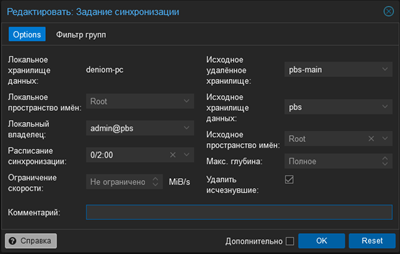

Вступление, или очередная проблема из неоткуда Система бэкапов Proxmox (PBS) является достаточно мощным и удобным инструментом для создания резервных копий виртуальных машин Proxmox, но она имеет одну проблему, которая мешала мне для организации задуманной мной системы домашнего сервера. PBS не может делать синхронизацию с удаленным каталогом по протоколу SAMBA. Синхронизация бэкапов в PBS доступна только между несколькими экземплярами самого сервера бэкапов, то есть для переноса бэкапов на другое устройство там должен быть установлен Debian с пакетом PBS. Альтернативой может являться создание хранилища данных в удаленной папке, созданной по протоколу NFS. В моем случае стояла задача восстановить исходную схему резервирования бэкапов, которая была реализована до перехода на создание бэкапы с помощью PBS, когда резервные копии также переносились на мой основной компьютер, откуда отправлялись на внешний диск. Так как основной компьютер работает под управлением Windows, возникли неожиданные сложности. NFS не поддерживается не серверными версиями Windows, остаются только сторонние варианты реализации. Но и в такой ситуации есть ряд подводных камней, фактически NFS будет являться просто сетевой папкой, куда складываются бэкапы, следовательно для резервного копирования в момент выполнения задачи компьютер с данной папкой должен быть включен. В результате моих поисков было найдено два основных варианта для решения поставленной задачи: 1. Запустить виртуальную машину с PBS 2. Запустить PBS в Docker-контейнере В дальнейшем я выбрал вариант запуска через Docker-контейнер, так как он для меня оказался более удобным и менее прожорливым по ресурсам (вся система Docker с запущенным PBS потребляет до 700 Мб ОЗУ). Также мне было откровенно лень разбираться с пробросом портов из виртуальной машины и еще пачкой ненужных задач. Для виртуальных машин Proxmox - ван лав. Так же данный способ подойдет для запуска на NAS. Установка и запуск PBS в докере Данный способ является не рекомендуемым и явно не поддерживаемым, для большей стабильности рекомендую использовать вариант запуска через виртуальную машину. Настройка синхронизации между двумя экземплярами PBS будет описана в следующем разделе. Для установки PBS на Debian в виртуалке приведен на оффициально сайте: https://pbs.proxmox.com/docs/installation.html#install-proxmox-backup-server-on-debian Для запуска докер в Windows необходимо установить docker desktop с официального сайта https://www.docker.com/products/docker-desktop/ для полноценной работы потребуется регистрация на докер хаб. После установки и первого запуска попадаем в стартовое окно docker desktop которое на самом деле очень бесполезное, в дальнейшем он нам понадобиться только для администрирования контейнера. В принципе этой установки должно быть достаточно, но лучше так же установить WSL если не был установлен ранее. Идем в Microsoft Store (да на удивление он все еще живой, сам в шоке) и находим там Windows Subsystem for Linux. Данная подсистема предназначена для запуска Linux системы прямо в Windows без использования стороннего софта для виртуализации, а так же его использует докер. Переходим в настройки докера и включаем запуск при старте Windows и включаем WSL2/ В принципе данных настроек должно быть достаточно для запуска необходимого нам контейнера. Но дополнительно настроим что бы докер не съедал наши ресурсы до бесконечности, по умолчанию потребление. Идем в основную папку пользователя: C:\Users\UserName И создаем там файлик со следующим именем: .wslconfig Открываем файл через любой текстовый редактор (рекомендую Notepad ++) И вставляем следующий конфиг: [wsl2] memory=1GB processors=1 Данная настройка вступит в силу после перезагрузки компьютера. Таким образом мы ограничиваем работу докера что бы он мог использовать не более 1Гб озу и не более одного виртуального ядра, чего для наших задач достаточно. Отдельно отмечу что минимальный объем может быть 1Гб так как происходит округление до целых значений. Данное ограничение действует на весь WSl в целом. Подробней о данном конфиг файле можно почитать тут: https://learn.microsoft.com/ru-ru/windows/wsl/wsl-config На этом предварительный этап закончен, приступаем непосредственно к запуску PBS. Сам проект задумывался для того что бы запускать PBS на NAS с поддержкой докера что в принципе является не плохим решением. Подробней с ним можете ознакомиться по ссылке: https://github.com/ayufan/pve-backup-server-dockerfiles Приступаем к запуску, для этого создадим папку в которой будет храниться конфиги и все данные нашего PBS (при желании можно развести их по разным папкам путем модификации docker compose). Нам потребуется вот такая структура папок: Создаем в корнейвой папке новый файл с именем docker-compose.yml и вставляем следующий конфиг: version: '2.1' services: pbs: image: ayufan/proxmox-backup-server:latest container_name: pbs hostname: hostName mem_limit: 128Mb environment: - TZ=Europe/Moscow volumes: - D:\Proxmox Backup Server\etc:/etc/proxmox-backup - D:\Proxmox Backup Server\logs:/var/log/proxmox-backup - D:\Proxmox Backup Server\lib:/var/lib/proxmox-backup - D:\Proxmox Backup Server\backups:/backups ports: - 8007:8007 tmpfs: - /run restart: unless-stopped stop_signal: SIGHUP Изменяем параметры volumes на свои а так же устанавливаем hostname для адекватного отображения имени хоста в интерфейсе PBS. Сохраняем файл и открываем консоль windows. Вводим стандартную команду запуска docker compose docker compose up -d В моем случае произошёл перезапуск контейнера, при первом запуске будет вывод о загрузке и сборке image. Возвращаемся в окно docker desktop и видим появившийся новый контейнер и потребление выделенных ресурсов. Фактическое потребление (зарезервировано) для системы в моем случае: На это этап запуска PBS в докере закончен, приступаем к непосредственной настройке синхронизации. Настройка нового экземпляра PBS Заходим в веб морду нашего нового экземпляра PBS по адресу: https://<Ip-pc>:8007/ По умолчанию доступен один пользователь: admin с паролем pbspbs Заходим в систему и приступаем к настройке. Нам необходимо создать хранилище данных, для этого нажимаем «Добавить хранилище данных». Путь к хранилищу указываем на папку, которую прокинули из компьютера для хранения бэкапов. Тут же настроим задание проверки резервных копий на целостность. Следующим шагом необходимо настроить права для работы с полученным хранилищем. Идем в радел управление доступом и создаем нового пользователя: Нам необходимо создать нового пользователя и сменить пароль для существующего. Так же выдаем права пользователю: В моем примере хранилище данных называется deniom-pc. В хранилище данных должно быть так: Настройка синхронизации между экземплярами PBS Основные настройки будут происходить на вторичном PBS который будет вытягивать бэкапы из PBS на хосте proxmox. Данные настройки выполняем под пользователем admin так как могут быть проблемы с правами. Подключаться мы так же будет через root пользователя к основному серверу. В идеале необходимо разграничивать права и использовать ограниченного пользователя. Переходим в удаленные хранилища, и добавляем новое подключение Заполняем данные для авторизации на основном сервере PBS. Отдельно надо отметить поле отпечаток, он нужен для установки ssl соединения между нашими системами. Что бы его получить возвращаемся в интерфейс PBS основного сервера PBSи на вкладке панелью мониторинга нажимаем показать отпечаток. Переходим в хранилище данных и настроим синхронизацию В данной настройке будет выполняться попытка синхронизации каждых два часа. Заключение На этом настройка фактически завершена, на самом деле мы имеем практически полноценный экземпляр PBS. Так же мы можем подключить данный экземпляр PBS напрямую к proxmox и делать бэкапы прямо в него, данное решение будет удобно для установки на NAS. Спасибо за внимание.

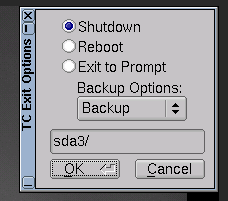

-

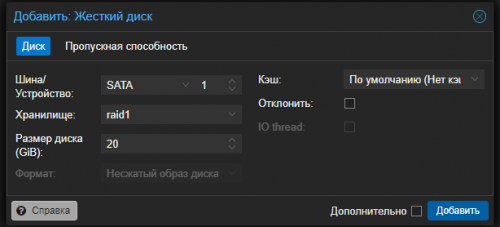

- 2

-

-

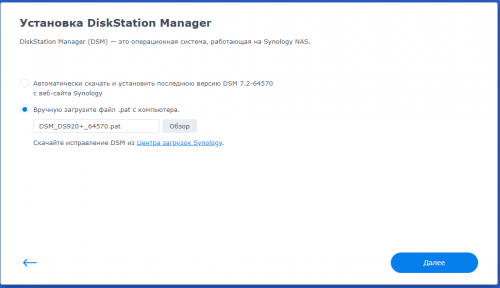

- pbs

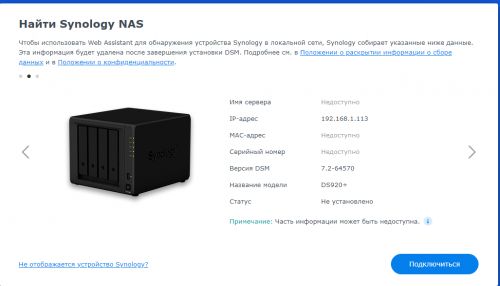

- proxmox backup serve

-

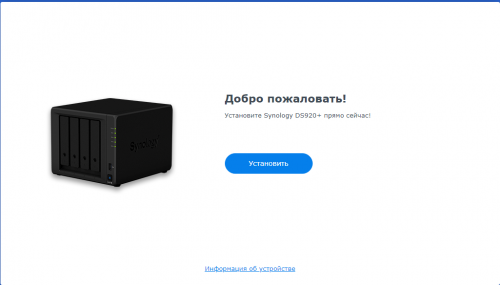

(и ещё 2 )

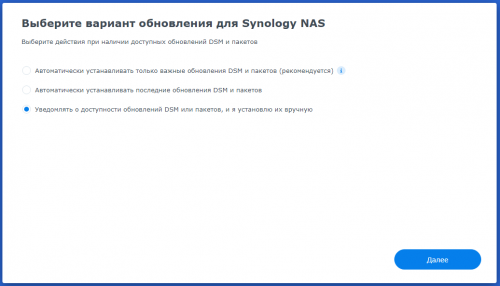

C тегом:

-

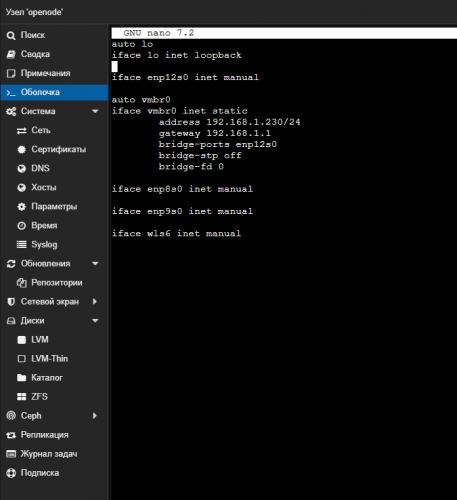

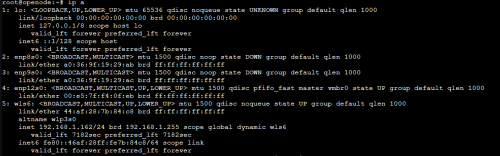

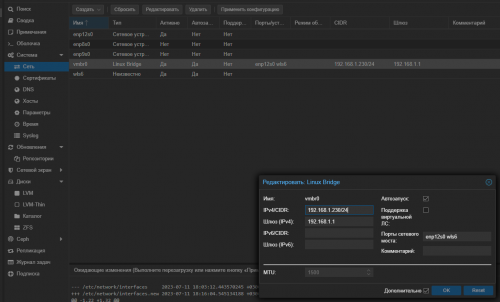

Всем привет Решил немного отдельных тематических тем создать под задачи с которыми сталкиваюсь, и как решаю. В общем. Сейчас у меня сервер подключен по кабелю через пол квартиры, иначе никак ни зайти ни настроить. Учитывая что у меня куплен wifi адаптер в pcie слот, глупо им не пользоваться. Итак. Ставим WiFi на Proxmox 8. Это не сложно. Первым делом нам нужно установить два пакета для работы с Wi-Fi: apt-get install -y wpasupplicant apt-get install wireless-tools Узнаём конфиг по сетям для этого выполним команду: iwconfig Получим примерно такой вывод: Из чего понимаем, что нас интересует интерфейс связи wls6 (в моем случае) Далее идем редактировать файл /etc/network/interfaces nano /etc/network/interfaces У меня вид вот такой: Видим, что про wls6 нет ничего. Исправляем на такой вид дописав текст и закомментировав ненужную (изменяемую) строку: auto wls6 iface wls6 inet dhcp wpa-conf /etc/wpa_supplicant/wpa_supplicant.conf Теперь редактируем файл с параметрами подключения /etc/wpa_supplicant/wpa_supplicant.conf: nano /etc/wpa_supplicant/wpa_supplicant.conf Содержимое вставляем такое и заменяем названия сети и пароль к сети: country=RU ctrl_interface=DIR=/var/run/wpa_supplicant GROUP=netdev update_config=1 network={ ssid="your ssid" psk="your wifi password" scan_ssid=1 } Сохраняем файл, выходим и перезапускаем службу: sudo systemctl restart networking Кидаем в консоль команду ip a и видим, что у нас получилось подключиться к wifi: Отлично. Включаем службу в автозагрузку при перезапуске: systemctl enable wpa_supplicant.service Вам также необходимо запустить dhclient во время загрузки, чтобы получить частный IP-адрес от вашего DHCP-сервера. Этого можно достичь, создав сервисный блок systemd для dhclient: nano /etc/systemd/system/dhclient.service Вставляем туда код ниже, не забыв заменить интерфейс: /etc/systemd/system/dhclient.service * [Unit] Description= DHCP Client Before=network.target After=wpa_supplicant.service [Service] Type=forking ExecStart=/sbin/dhclient wls6 -v ExecStop=/sbin/dhclient wls6 -r Restart=always [Install] WantedBy=multi-user.target Теперь перезапускаем сервис: systemctl restart wpa_supplicant.service И ещё раз перезапускаем сеть: systemctl restart networking Теперь сетевой интерфейс доступен по этому адресу: 192.168.1.162:8006 Но, на этом ещё не все. Для правильности всех настроек, нам нужно провалиться в параметры сети: И указать в портах сетевого моста wls6 Чтобы применить изменения, нужно перезапустить наш узел = сервер: Узлом называется потому что мы можем собрать в одной сети несколько серверов в кластер. Кнопка сверху при активном "узле": Но, теперь если отключить сеть проводную - пропадет весь доступ... Получается, что по wifi-сеть не держится. Пока я не смог решить эту проблему Хоть и перенастроил bridge и оставил там только шлюзы для wifi... Если кто то сталкивался, подскажите UPD: Вероятная причина в отсутствии драйверов для моей сетевой карты TP-LINK T5E - нет поддержки Linux